HPE

- 1. Что такое HPE StoreVirtual? Что такое LeftHand?

- 2. Как можно подключить серверы к СХД StoreVirtual 3200?

- 3. Какие особенности имеет SV3200? Какие технологии хранения данных в ней реализованы?

- 4. Чем StoreVirtual 3200 отличается от других SAN СХД производства HPE?

- 5. Чем отличаются СХД MSA 20X0 и MSA 20X2?

- 6. Как устроены СХД HPE Nimble Storage?

- 7. Какие модели СХД входят в семейство HPE Nimble Storage?

- 8. Чем отличаются стример, автозагрузчик и ленточная библиотека?

- 9. Что такое файловый контроллер (файловый шлюз)?

- 10. Какие изменения были сделаны в 6м поколении СХД HPE MSA (MSA 1060/2060/2062)?

- 11. В чем различие между HPE 3PAR 8450 и 9450? Будет ли 8450 заменен 9450?

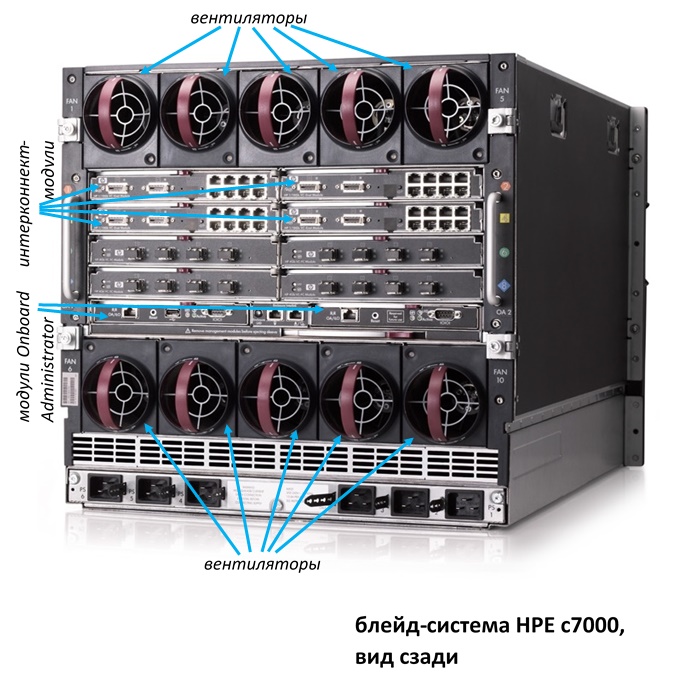

- 12. Что такое программно-определяемое хранилище (Software Defined Storage, SDS)?

- 13. Что такое виртуальная ленточная библиотека? Какие виртуальные библиотеки предлагает компания HPE?

- 14. Какие модели входят в линейку СХД HPE 3PAR 8000? В чем различия между ними?

- 15. Как устроены СХД HPE 3PAR 8000?

- 16. Как лицензируются программные функции в СХД HPE 3PAR?

- 17. Что такое Service Processor в СХД HPE 3PAR?

- 18. Какие решения по хранению данных компании HPE поддерживают прямое подключение к серверам?

- 1. В чем особенности технологий организации оперативной памяти UDIMM, RDIMM, LRDIMM и NVDIMM?

- 2. Что такое репликация? В чем отличия синхронной и асинхронной репликации?

- 3. Что такое RPO и RTO?

- 4. Что такое тиринг? Что такое MSA Virtual Tier Affinity?

- 5. Что такое дедупликация? В чем ее отличие от компрессии (сжатия данных)?

- 6. Что такое inline и post-processing режимы дедупликации и компрессии? Что показывает коэффициент дедупликации/компрессии?

- 7. Что такое сетевой RAID (на примере HPE StoreVirtual 3200)?

- 8. Какие новые технологии реализованы в серверах HPE ProLiant Gen.10?

- 9. Что такое Nimble Storage InfoSight? Каковы особенности ее работы?

- 10. Что такое HPE SmartCache?

- 11. Какие технологии реализованы в СХД HPE Nimble Storage?

- 12. Чем различаются интерфейсы SAS и SATA?

- 13. Какие технологии и программные функции реализованы в СХД HPE 3PAR?

- 14. Каким образом реализован функционал репликации в СХД HPE 3PAR? Что такое RCFC, RCIP, FCIP, SLD?

- 15. В чем смысл технологии Network Partitioning (NPAR)?

- 16. Что такое NVMe? В чем его отличие от SATA и SAS?

- 17. Что такое Storage Class Memory? Что такое HPE 3PAR 3D Cache?

- 1. Какие основные типы серверов производятся компанией HPE? Какие обозначения для них приняты?

- 2. Что такое поколение серверов? Какое поколение серверов HPE является актуальным на текущий момент?

- 3. В чем основные отличия между линейками стоечных серверов семейства ProLiant DL Gen.9?

- 4. В чем основные отличия между линейками башенных серверов семейства ProLiant ML Gen.9?

- 5. Что такое блейд-система? Из каких компонентов она состоит?

- 6. Какие особенности имеет компонуемая инфраструктура HPE Synergy? В чем ее отличие от блейд-систем c-class?

- 7. Что такое гиперконвергентные (hyper-converged) системы?

- 8. Поддерживается ли установка клиентских ОС (например, Windows 10) на серверы HPE ProLiant?

- 9. Какие серверы семейства HPE ProLiant Gen.10 доступны для заказа?

- 10. Планируется ли дальнейшее развитие блейд-серверов HPE ProLiant BL и блейд-систем c-class?

- 11. Какие модели входят в семейство блейд-серверов HPE ProLiant BL? В чем особенность модели WS460c Graphics?

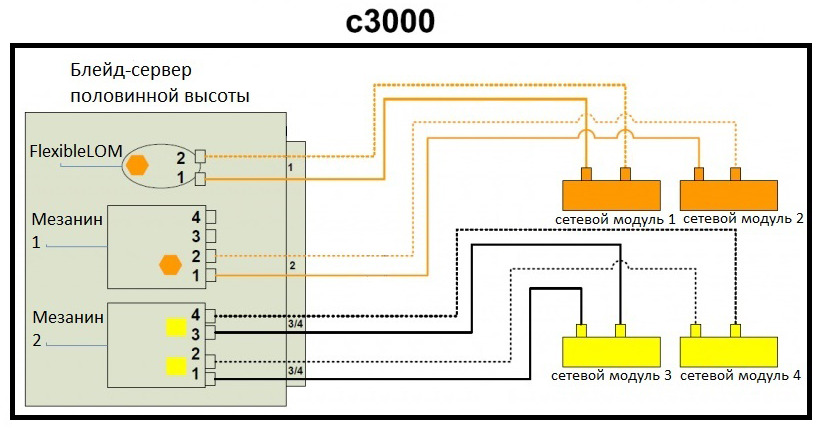

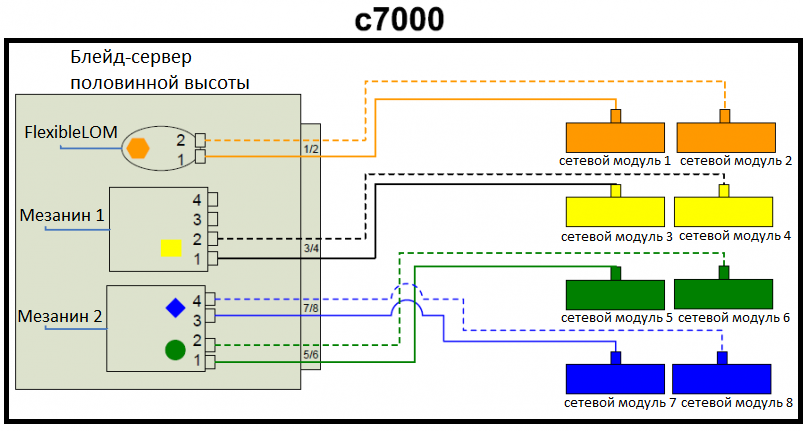

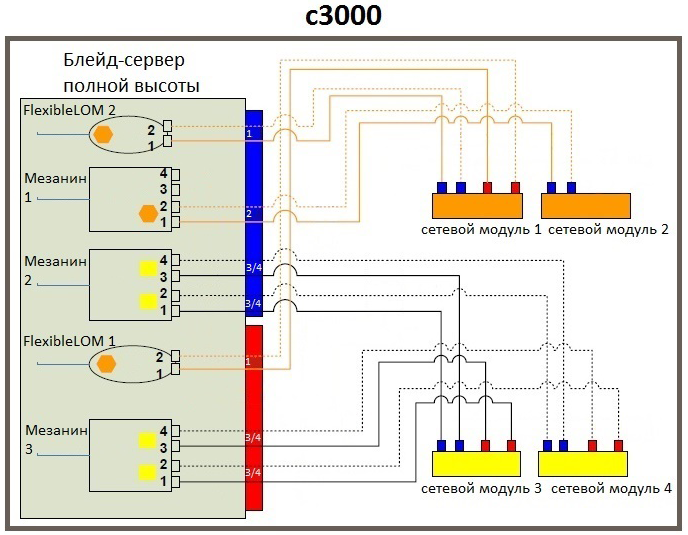

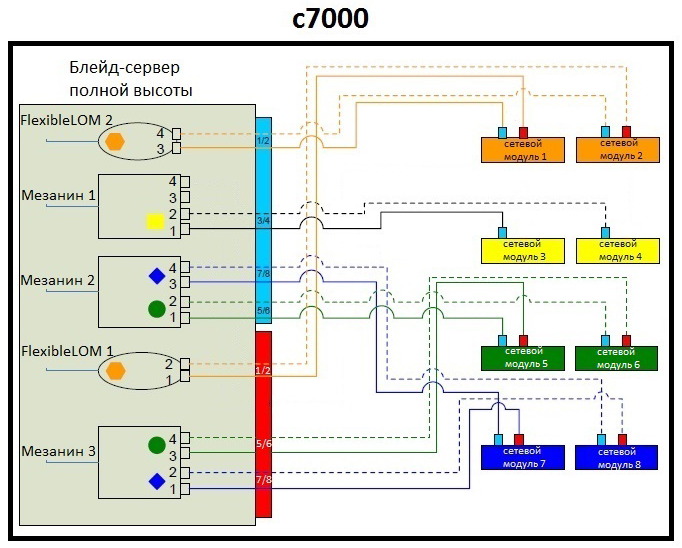

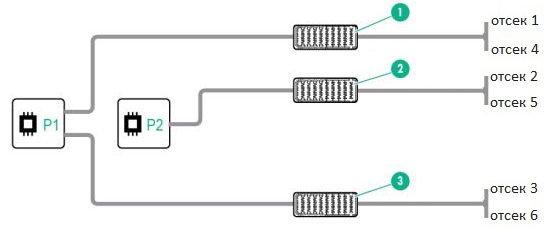

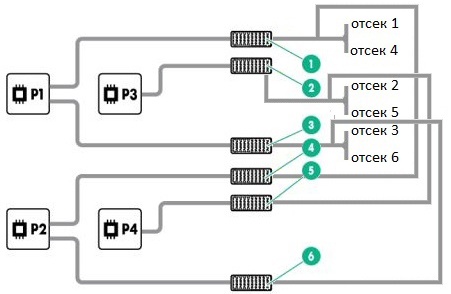

- 12. Как порты сетевых адаптеров блейд-сервера подключаются к сетевым модулям в блейд-системах c3000 и c7000?

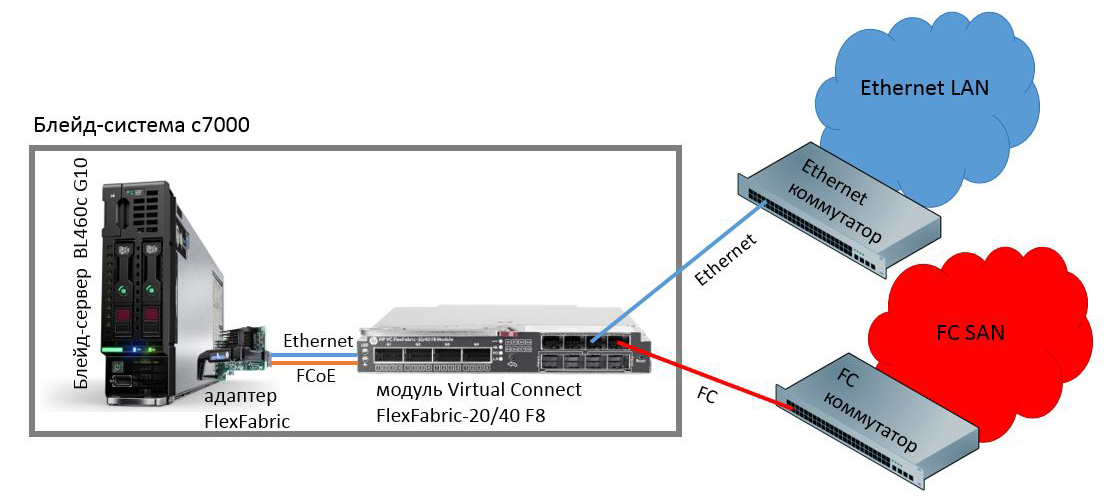

- 13. В чем особенность сетевых модулей HPE Virtual Connect?

- 14. В чем смысл архитектуры сетевых модулей «Мастер-Спутник» в системах HPE Synergy?

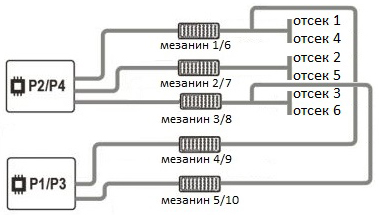

- 15. Как порты сетевых адаптеров вычислительных модулей подключаются к сетевым модулям в системе HPE Synergy? Какие имеются рекомендации по установке сетевых модулей?

- 1. Какие варианты подключения по 10 Гбит/с существуют на оборудовании HPE?

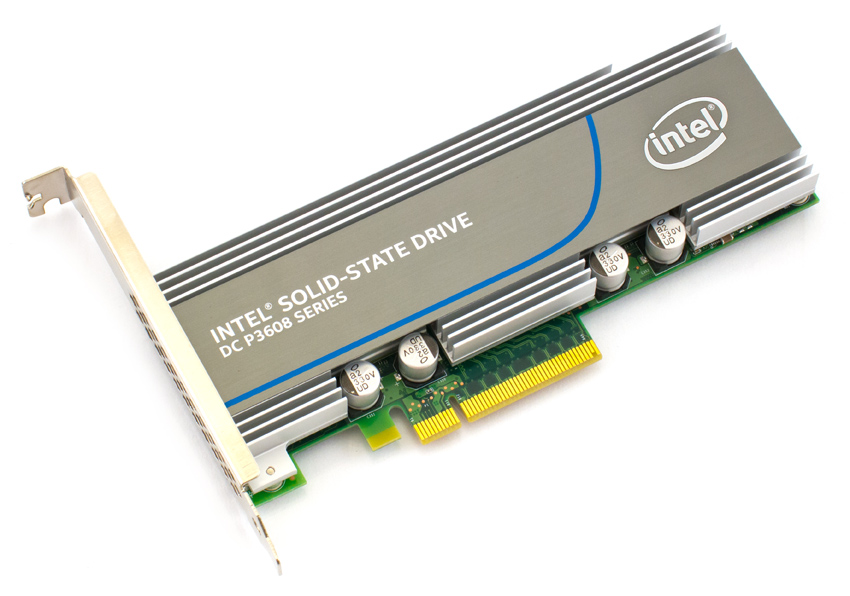

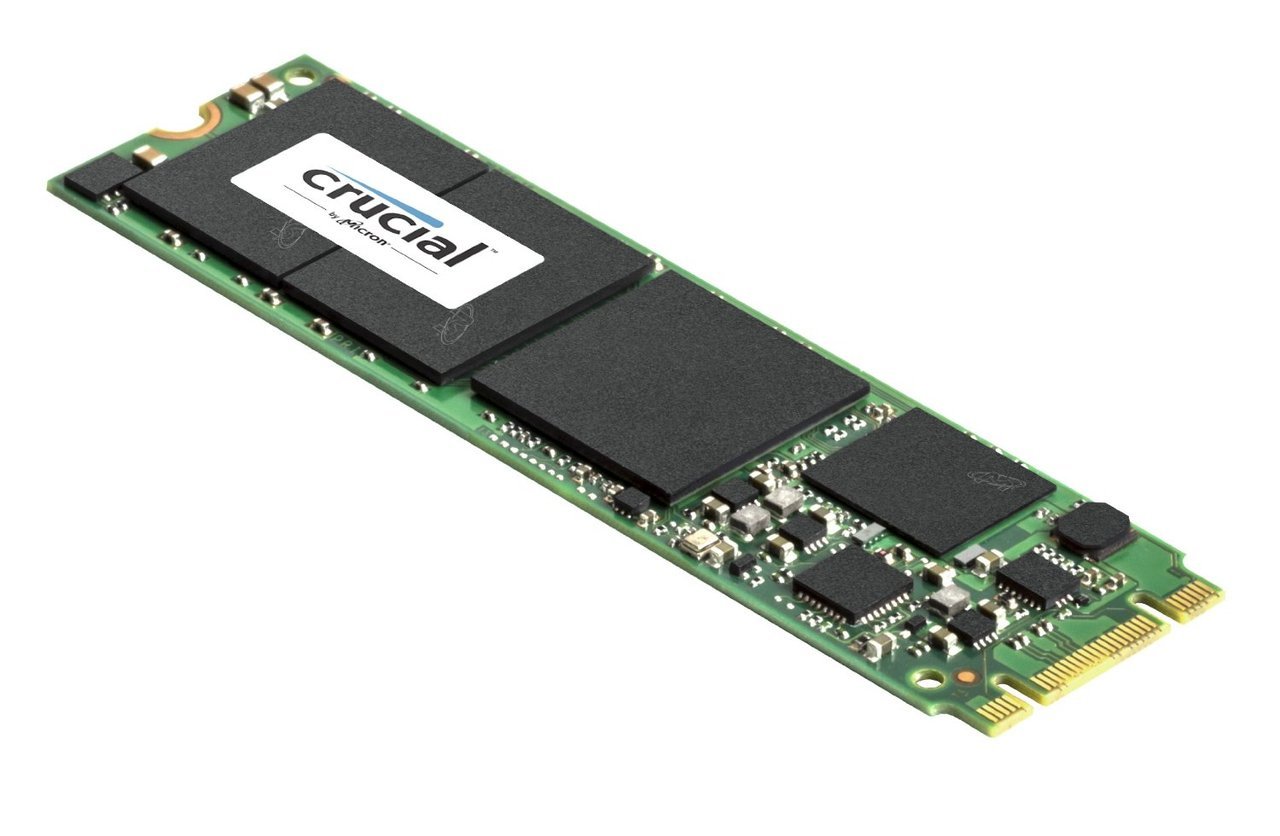

- 2. Какие варианты SSD накопителей поддерживаются на оборудовании HPE? В чем разница между RI, WI, MU SSD?

- 3. Какие варианты HDD дисков поддерживаются на оборудовании HPE? Что такое SAS Fast Class, Enterprise, Midline, Nearline?

- 4. Какие новые комплектующие были добавлены в серверы HPE ProLiant Gen.10?

- 5. Что означает опция FBWC в RAID-контроллерах HPE Smart Array? Зачем нужна батарея Smart Storage Battery?

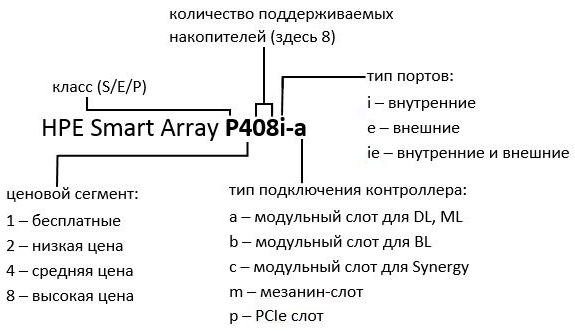

- 6. Как изменилось семейство RAID-контроллеров Smart Array на серверах Gen.10?

- 7. Что такое HPE iLO? Чем отличаются iLO Standard, Scale-Out, Essentials, Advanced, Advanced Premium Security Edition?

- 8. В чем разница между IOPS и МБ/с (ГБ/с)?

- 9. Где можно скачать обновления прошивок и драйверов для оборудования HPE? Являются ли они общедоступными?

- 10. В чем особенность сетевых адаптеров HPE FlexFabric?

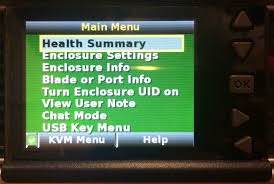

- 11. Что такое Systems Insight Display на серверах HPE серии DL? Чем он отличается от Insight Display на блейд-системах c-class?

- 1. В чем особенности различных уровней технической поддержки HPE Packaged Services?

- 2. Что такое HPE Pointnext, HPE Packaged Services? Что стало с пакетами услуг HP CarePack?

- 3. Какие ограничения имеет стандартная гарантия на оборудование HPE? Какие преимущества дает заказчику приобретение расширенной поддержки?

- 4. Что такое время реакции? Для чего служат обозначения NBD, CSR, CTR, DMR, CDMR?

- 5. Что означает формула вида «3-3-3», описывающая стандартную гарантию на оборудование HPE? С какого момента исчисляется гарантийный срок?

- 6. Возможно ли продлить действие гарантии, поддержки или сервисного контракта после окончания их срока?

- 7. Аннулируется ли гарантия при установке стороннего компонента в оборудование HPE?

- 8. В чем особенность гарантии на SSD накопители для СХД HPE 3PAR?

- 9. В чем разница между коммерческими (FIX) и корпоративными (FLEX) пакетами расширенной поддержки HPE Packaged Services?

Что такое HPE StoreVirtual? Что такое LeftHand?

StoreVirtual – семейство СХД типа SAN, выпускаемых компанией HPE. Существуют 2 линейки СХД StoreVirtual: традиционная SV 4000 и новая SV 3000. Серия 4000 готовится к снятию с производства. Серия 3000 недавно вышла на рынок, и на февраль 2017 года представлена единственной моделью – SV3200.

СХД StoreVirtual работает под управлением специальной операционной системы. В серии SV 4000 данная ОС носила название LeftHand, и иногда под этим названием подразумевают всю СХД SV целиком. В серии SV 3000 ОС имеет уже другое название – StoreVirtual OS.

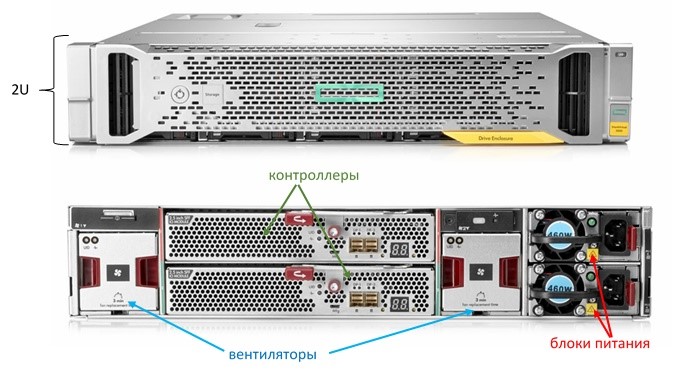

SV3200 реализовано в виде шасси размером 2U. Спереди находится 25 SFF либо 12 LFF слотов под накопители, а сзади размещаются блоки питания, вентиляторы и контроллеры в отказоустойчивой конфигурации (каждый элемент в количестве 2).

Контроллеры обеспечивают работу всего массива и управление им. Кроме того, именно контроллеры оснащены портами, позволяющие подключить СХД к SAN сети и обеспечить блочный доступ к хранилищу для серверов.

Как можно подключить серверы к СХД StoreVirtual 3200?

SV3200 поддерживает подключение по iSCSI 1 и 10 Гбит, а так же по Fibre Channel 8 и 16 Гбит (в рамках одной СХД возможен только один тип подключений).

- При подключении iSCSI 1 Гбит используется 2 или 4 порта на контроллер, порты медные

- При подключении iSCSI 10 Гбит используется 2 порта на контроллер, возможны как медные порты, так и оптические SFP+ трансиверы

- При подключении FC 8/16 Гбит используется 2 порта на контроллер, оптические SFP+ трансиверы SV3200 подключается к серверам через SAN коммутаторы (Ethernet/FC). На февраль 2017 года, прямое подключение от SV3200 непосредственно к серверам не поддерживается.

Какие особенности имеет SV3200? Какие технологии хранения данных в ней реализованы?

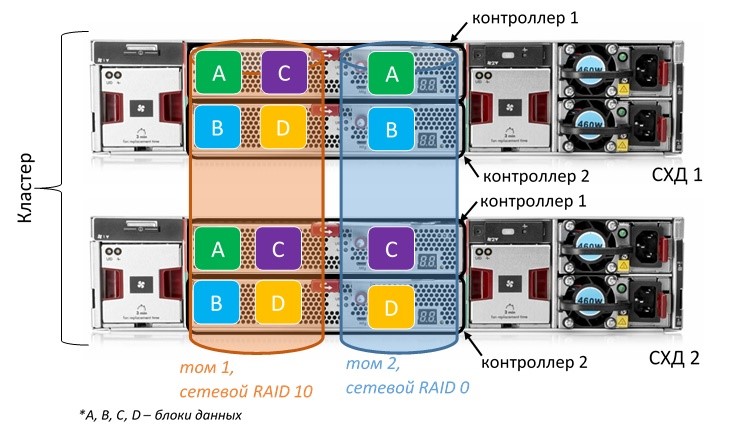

Ключевой особенностью StoreVirtual 3200 является возможность объединения нескольких СХД в кластер и построения сетевых RAID конфигураций на базе данного кластера. Сетевой RAID по принципу своей работы аналогичен классическому RAID, только его элементами являются не отдельные диски, а отдельные контроллеры СХД. Каждый том (LUN), находящийся в кластере, может иметь свой собственный уровень сетевого RAID. На февраль 2017 года, поддерживается объединение в кластер до двух SV3200.

Передача данных между разными СХД в рамках кластера и сетевых RAID конфигураций осуществляется за счет синхронной репликации. При наличии адекватного канала связи, можно разместить участвующие в кластере СХД на географически удаленных площадках и получить катастрофоустойчивое решение (которое обеспечивает полную сохранность данных и автоматическое переключение клиентов при аварии на одной из площадок).

Помимо сетевых RAID и синхронной репликации, StoreVirtual 3200 имеет большинство функций современных СХД:

- Тома с динамическим выделением емкости, занимающие лишь то место, которое реально занято пользовательскими данными. Размер томов увеличивается или уменьшается в зависимости от изменений объемов пользовательских данных (англ. Thin Provisioning, Space Reclamation);

- Перемещение томов между СХД или кластерами в онлайн-режиме, без остановки работы приложений, использующих данные тома (англ. Peer Motion);

- Традиционные снимки данных, а также снимки с учетом состояния приложений;

- Автоматический тиринг;

- Асинхронная репликация.

Тиринг и репликация требуют дополнительную лицензию Advanced Data Services. Данная лицензия также требуется для построения сетевого RAID между двумя СХД, поскольку он работает именно за счет синхронной репликации.

Дополнительно можно приобрести файловый шлюз StoreVirtual 3000 File Controller, который добавит поддержку файлового доступа по всем основным протоколам (SMB, CIFS, NFS и т.д.) для SV3200. Кроме того, он добавит дедупликацию на уровне элементов файлов и ряд функций для файлового хранилища (классификация, файловые квоты и т.д.).

Чем StoreVirtual 3200 отличается от других SAN СХД производства HPE?

StoreVirtual 3200 – одна из трех основных SAN СХД компании HPE (наряду с MSA и 3PAR).

StoreVirtual 3200 по своим характеристикам и цене ближе к MSA, она так же относится к бюджетному сегменту. Но, с другой стороны, SV3200 имеет ряд функций, которых нет в MSA и которые встречаются в массивах более высокого уровня, таких как 3PAR.

Преимущества SV3200 по сравнению с MSA:

- имеет меньшую цену (на 6-7% меньше чем даже MSA 1040 при одинаковых конфигурациях)

- имеет более богатый функционал (присутствует сетевой RAID, Peer Motion, которых нет в MSA)

Недостатки SV3200 по сравнению с MSA:

- хуже производительность – и при стандартной конфигурации MSA, и тем более при использовании на MSA функции кэширования на SSD, которой нет в SV3200

- не поддерживается (на февраль 2017 года) прямое подключение SV3200 к серверам, что может потребовать дополнительных затрат на покупку SAN коммутаторов

StoreVirtual 3200 хорошо подойдет:

- при необходимости синхронной репликации между СХД (резервная площадка, катастрофоустойчивое решение)

- как более бюджетный аналог MSA для всех основных корпоративных задач (файловая помойка, резервное копирование, телефония, почта, виртуализация и т.д.), особенно если в инфраструктуре заказчика уже имеется SAN сеть с коммутаторами

| StoreVirtual 3200 | MSA 1040/2040 | 3PAR | |

| Цена | Наименьшая | Дороже чем SV3200 | Значительно дороже |

| Производительность | Самая низкая | Выше чем в SV3200 | Значительно выше |

| Прямое подключение к серверам | Не поддерживается | Поддерживается | Не поддерживается |

| Асинхронная репликация | Да, лицензируется дополнительно | Да, лицензируется дополнительно | Да, лицензируется дополнительно |

| Синхронная репликация | В рамках сетевого RAID, лицензируется дополнительно | Нет | Да, лицензируется дополнительно |

| Тиринг | 2х уровневый, лицензируется дополнительно | 3х уровневый, лицензируется дополнительно (2х уровневый входит по умолчанию в MSA2040) | Собственная технология (перемещение данных между CPG), лицензируется дополнительно |

| Дедупликация | Только файловая при использовании файлового контроллера | Только файловая при использовании файлового контроллера | Да |

Чем отличаются СХД MSA 20X0 и MSA 20X2?

HPE MSA (англ. Modular Smart Array) – семейство SAN СХД начального уровня. В него как правило, входят три модели с индексами MSA 10X0, MSA 20X0 и MSA 20X2, где X указывает на поколение модели. Фактически, MSA 20X2 является той же самой MSA 20X0, только в определенной комплектации. В состав MSA 20X2 обязательно входят следующие компоненты:

- Стандартное шасси MSA

На 12 LFF, либо 24 SFF накопителей, с 2 кабелями питания и комплектом направляющих для стойки.

- Два контроллера

Пара контроллеров типа SAS, FibreChannel или iSCSI с 4 портами в каждом, с поддержкой до 9 корзин накопителей (Разные поколения имеют различия по максимальному количеству подключаемых корзин).

- Два SSD накопителя

Для обеспечения тиринга. Используются диски с интерфейсом SAS 12 Гбит/с, различных типов: Read intensive (Повышенная способность считывания/записи), SSD типа Mainstream Endurance (С повышенным показателем Drive Writes per Day) или Mixed use SSD. - Лицензия Advanced Data Services

Открывает все расширенные функции для MSA - Два уровня хранения (Performance Tiering), до 512 снапшотов на систему (у MSA 10X0 и 20X0 без лицензии – 64 снапшота), Функция RSR (Remote Snap Replication).

Для моделей MSA 10X0 и 20X0 лицензия ADS Suite (Advanced Data Services) является опциональной. Лицензия потребуется, если необходимо разделение на уровень производительности (Performance tier) и нижние уровни (Standard и Archive) в рамках одного HDD-пула.

MSA 20X2 имеет преимущество в цене по сравнению с аналогичной конфигурацией на MSA 20X0, и стоит примерно на 20% меньше.

Как устроены СХД HPE Nimble Storage?

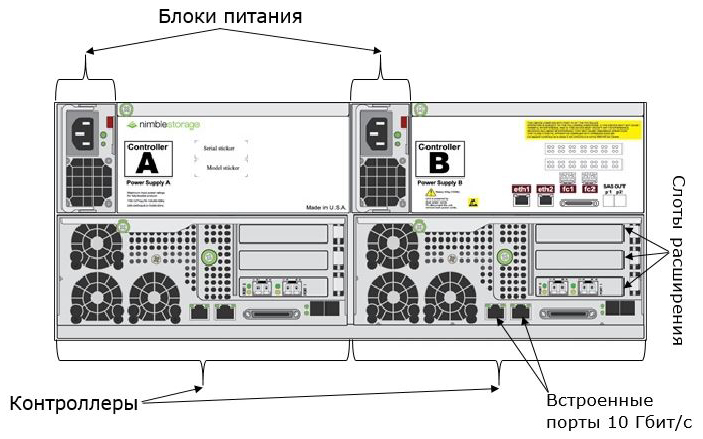

Массивы HPE Nimble Storage состоят из основного шасси и опциональных полок расширения. Шасси имеет размер 4U и включает 2 контроллера, 2 блока питания и накопители. Полки расширения также имеют размер 4U и включают аналогичные элементы. Полки расширения бывают all-flash (состоящие полностью из SSD), либо гибридные (включающие HDD и SSD под кэш).

Контроллеры основного шасси снабжены двумя встроенными медными портами 10 Гбит, которые по умолчанию настроены для сети управления, но могут использоваться и для клиентских подключений. Также контроллеры имеют 3 слота расширения, в которые можно устанавливать сетевые карты 1/10 Гбит iSCSI и 8/16 Гбит FC. На начало 2018 года, нельзя использовать одновременное подключение по iSCSI и FC (исключение – iSCSI используется для репликации, FC для клиентского доступа). В планах заявлено скорое добавление данной возможности, а также карт 40 Гбит iSCSI и 32 Гбит FC. Контроллеры работают по схеме Active-Passive, то есть один из них является активным, а другой находится в режиме ожидания и берет на себя функции управления в случае отключения первого. Данная схема позволяет легко производить последовательную замену контроллеров при апгрейде. Кроме того, в ней отсутствуют ограничения по загрузке контроллера не более чем на 50%, присущие архитектурам Active-Active.

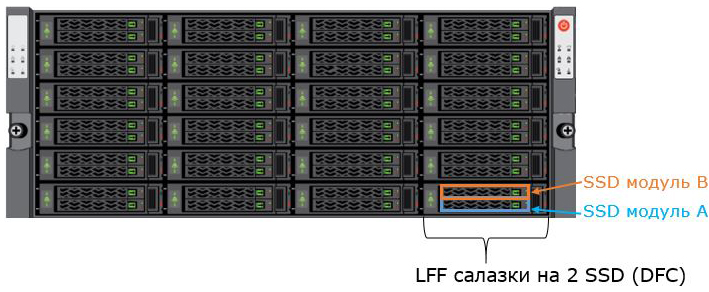

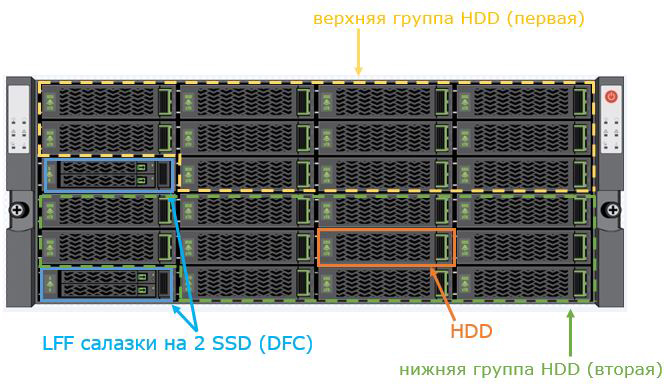

Массивы серии AF включают до 48 SSD накопителей. Они установлены парами в специальных модулях (англ. Bank), каждая пара находится в LFF салазках DFC (англ. Dual Flash Carrier). Нижние накопители каждой пары принадлежат к модулю А и образуют первую RAID-группу. Верхние накопители каждой пары принадлежат к модулю В и образуют вторую RAID-группу. Массивы серии AF поддерживают до 2 all-flash полок расширения. Заказчик может приобрести основное шасси с 24 (заполнены только модули А) или 48 SSD.

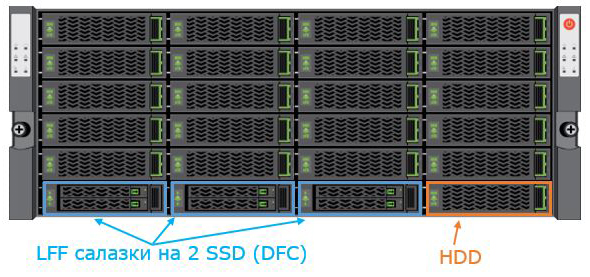

Массивы серий CS (за исключением CS1000H) и SF включают до 6 SSD (в 3 DFC) и 21 LFF HDD накопитель. SSD используются под кэш на чтение, и в основном шасси их может быть 3 (только модули А) либо 6. HDD всегда устанавливаются в количестве 21 и собираются в RAID-группу. Массивы серии CS поддерживают до 6 гибридных полок расширения. Кроме того, вместо 1 из них можно поставить полку all-flash. Массивы серии SF поддерживают до 2 гибридных полок расширения.

CS1000H представляет собой наиболее бюджетный вариант, он включает до 4 SSD (в 2 DFC) и до 22 HDD накопителей в основном шасси. В данном массиве можно начать с конфигурации 2 SSD (только модули А) и 11 HDD (верхние), а затем добавить группу 11 нижних HDD и, при необходимости, SSD модулей В.

Массивы серий AF и CS поддерживают апгрейд на более старшие модели путем замены контроллеров. С модели уровня 1000 можно последовательно обновиться до модели уровня 5000, с модели уровня 3000 – до уровня 9000. К примеру, можно получить AF7000 из AF3000 следующим образом: AF3000 обновляется до AF5000, затем AF5000 обновляется до AF7000. Модель CS1000H поддерживает обновление только до CS3000.

Кроме того, массивы серий AF и CS можно объединять в кластер с единым управлением и возможностью распределения данных томов между СХД (до 4 СХД). Для оптимальной балансировки ввода/вывода требуется установка специального драйвера на хосты.

Какие модели СХД входят в семейство HPE Nimble Storage?

Семейство HPE Nimble Storage включает три продуктовые линейки, различающиеся по архитектуре и назначению:

- AF-Series (англ. All-Flash) – массивы, полностью построенные на базе SSD накопителей; позиционируются для наиболее критичных рабочих нагрузок.

- CS-Series (англ. Converged Storage) – адаптивные массивы, в которых данные хранятся на HDD, а SSD используются в качестве кэша; позиционируются для большинства основных нагрузок.

- SF-Series (англ. Secondary Flash) – дополнительные массивы, которые по архитектуре аналогичны адаптивным, но имеют сниженную производительность и повышенные коэффициенты дедупликации; позиционируются для резервного копирования и некритичных нагрузок.

В указанные линейки массивов входят следующие модели:

| Линейка | Модель | Производительность* | Полезная емкость** |

| AF-Series | AF1000 | До 35 000 IOPS | До 165 ТБ |

| AF3000 | До 50 000 IOPS | До 335 ТБ | |

| AF5000 | До 120 000 IOPS | До 680 ТБ | |

| AF7000 | До 230 000 IOPS | До 1,2 ПБ | |

| AF9000 | До 300 000 IOPS | До 2 ПБ | |

| CS-Series | CS1000H | До 35 000 IOPS | До 1,9 ПБ |

| CS1000 | До 35 000 IOPS | До 1,9 ПБ | |

| CS3000 | До 50 000 IOPS | До 2,3 ПБ | |

| CS5000 | До 120 000 IOPS | До 2,3 ПБ | |

| CS7000 | До 230 000 IOPS | До 2,3 ПБ | |

| SF-Series | SF-100 | До 20 000 IOPS | До 800 ТБ |

| SF-300 | До 40 000 IOPS | До 1,6 ПБ |

*с учетом работающих дедупликации и компрессии

**с учетом RAID, дедупликации и компрессии

Необходимо отметить, что приведенные показатели по IOPS носят маркетинговый характер, они получены в результатах лабораторных тестов при оптимальных условиях. В условиях реальной эксплуатации, в зависимости от профиля нагрузки, массивы серии AF могут иметь лучшую производительность, чем модели того же уровня серии CS.

Чем отличаются стример, автозагрузчик и ленточная библиотека?

Стример или ленточный накопитель — устройство хранения данных, основанное на принципе магнитной записи на ленточный носитель (называется картриджем или кассетой). Стример работает через последовательный доступ к данным, и по своей организации он очень похож на обычный магнитофон. Для записи или чтения информации необходимо загрузить кассету в привод. Поскольку, с одной стороны, кассеты отличаются невысокой стоимостью и большой емкостью, а с другой, стример имеет низкую скорость произвольного доступа (лента должна прокрутиться к нужному месту), данные устройства чаще всего используются для резервного копирования и архивирования информации. Стримеры бывают внутренние (устанавливаются в корпус сервера, как дисковод) и внешние (отдельные устройства). Они могут подключаться через интерфейсы USB, SCSI или SAS. В портфеле решений HPE стримеры представлены семейством StoreEver Ultrium. Они поддерживают кассеты серии LTO-7 емкостью 15 ТБ (с учетом сжатия), а также более ранних серий вплоть до LTO-3 (зависит от модели стримера).

Стример StoreEver LTO-7 Ultrium 15000

Ленточный автозагрузчик – устройство хранения данных, объединяющее стример и магазин автоматической подачи, в который можно установить несколько кассет. Далее они будут последовательно, в автоматическом режиме загружаться в стример для записи. Ручная замена кассет в пределах магазина не требуется. Автозагрузчик может иметь интерфейс FC, SCSI или SAS. HPE в качестве автозагрузчика предлагает модель StoreEver 1/8 G2, поддерживающую магазин на 8 кассет.

Автозагрузчик StoreEver 1/8 G2

Ленточная библиотека – система, объединяющая в своем составе до десятков стримеров и позволяющая автоматически управлять записью на десятки и сотни лент. Может иметь внешний интерфейс FC или SAS. Ленточные библиотеки поддерживают очень большие объемы данных, они предназначены для автоматического резервного копирования и архивирования целых ИТ-инфраструктур. В портфеле решений HPE ленточные библиотеки представлены семейством StoreEver MSL (емкость до 8,4 ПБ* на LTO-7 с учетом сжатия, в зависимости от модели), а также моделями премиум-класса T950 (до 300 ПБ на LTO-8 с учетом сжатия) и TFinity ExaScale (до 1,6 ЭБ** на LTO-8 с учетом сжатия).

Ленточная библиотека StoreEver MSL2024

* ПБ – петабайт, 1 ПБ равен 1000 ТБ

** ЭБ – эксабайт, 1 ЭБ равен 1000 ПБ

Что такое файловый контроллер (файловый шлюз)?

Файловый шлюз – NAS* устройство, которое может подключаться к блочной SAN** СХД и превращать ее в NAS хранилище, добавляя поддержку файловых служб и протоколов. Подключение файлового шлюза к SAN СХД происходит посредством SAS, iSCSI или FC. Оно может идти непосредственно к массиву, либо через SAN сеть. Далее все клиентские подключения к СХД осуществляются через файловый шлюз по Ethernet LAN.

HPE в качестве файловых шлюзов предлагает решения StoreEasy 3850 Gateway Storage и StoreEasy 3850 Gateway Storage Blade. Первое выполнено в форм-факторе стоечного сервера, второе – в виде блейд-сервера. Данные шлюзы имеют предустановленную ОС Windows Storage Server 2016 и предоставляют все имеющиеся в ней сервисы (SMB, NFS, HTTP/HTTPS, FTP/FTPS, iSCSI, QoS, файловую дедупликацию и т.д.).

Решения StoreEasy 3850 Gateway Storage поддерживают следующие СХД: MSA, StoreVirtual, Nimble Storage, 3PAR, XP.

* NAS – англ. Network Attached Storage, сетевое файловое хранилище

** SAN – англ. Storage Area Network, сеть хранения данных

Какие изменения были сделаны в 6м поколении СХД HPE MSA (MSA 1060/2060/2062)?

HPE MSA – семейство систем хранения данных начального уровня. Осенью 2020 года вендор анонсировал 6е поколение СХД MSA и появились модели MSA 1060, MSA 2060 и MSA 2062 (третья цифра в названии указывает на поколение). На начало осени 2020 года, продолжают также официально поставляться модели MSA 5го поколения (MSA 1050/2050/2052). По сравнению с ними, СХД нового поколения имеют следующие преимущества и особенности:

- Максимальная производительность MSA 2060/2062 выше примерно в 1,5 раза по сравнению с аналогичными конфигурациями на 2050/2052 (согласно тестам HPE, 2050/2052 выдает до 220 тыс. IOPS, 2060/2062 – более 320 тыс. IOPS).

- MSA 2062 комплектуется двумя SSD по 1,92 ТБа (в 2052 входят два по 800 ГБ).

- Новое поколение комплектуется контроллерами, поддерживающими один из вариантов подключения: Fiber Channel (8\16Gb), iSCSI (1\10Gb) и SAS (12Gb). Контроллеры старших моделей MSA 2060 и MSA 2062 имеют по четыре порта. Модель MSA 1060 поставляются с двумя контроллерами, по два порта на каждом, с поддержкой кабеля «SAS Fan-out cable Y», позволяющим удвоить число портов до восьми.

- MSA 1060 может дополняться четырьмя корзинами с 24 дисками SFF или тремя корзинами от MSA 2060 на 24 SFF или 12 LFF, с возможностью комбинирования. Модели MSA 2060 и MSA 2062 поддерживают до девяти корзин накопителей. С системами MSA Gen6 нельзя использовать корзины расширения от систем предыдущих поколений. Так же диски 6го поколения MSA не подходят для систем других поколений.

- Новое поколение получило более производительные CPU и микросхемы ASIC для разгрузки RAID;

- Новый тип группы дисков – MSA-DP+. Он использует интегрированное резервирование, не оставляющее не работающих дисков. Обеспечивает поддержку дисков разной ёмкости, гибкое расширение от 12 до 128 дисков и существенно более быстрое восстановление массива.

- Обновленная версия механизма многоуровневого хранения «Tiering v2.0». По заявлению HPE, улучшенный алгоритм анализа «горячих» данных может обеспечить прибавку к IOPS до 45%.

- Поддержка сервиса HPE Cloud Volumes Backup, использующегося для быстрого и простого резервного копирования в облако.

Модель MSA 1060 поставляется только с корзинами под форм-фактор SFF-накопителей, но есть возможность использовать корзины от MSA 2060 (до трёх). В такой конфигурации накопители SFF и LFF могут использоваться вместе.

Апгрейд с MSA 1050/2050/2052 на соответствующие модели 6го должен производиться через резервное копирование и восстановление данных с помощью специальных средств, чтобы перенести данные с бывшего массива на новый массив Gen6.

В чем различие между HPE 3PAR 8450 и 9450? Будет ли 8450 заменен 9450?

HPE 3PAR StoreServ 9450 – новая модель в семействе систем хранения данных 3PAR, анонсированная вендором летом 2017 года. Данная СХД позиционируется как All-Flash, то есть построенная только на SSD накопителях (добавление HDD официально не поддерживается). Она относится к среднему классу (англ. Midrange) и занимает нишу между линейкой начального уровня 8000 и линейкой премиум-класса 20000 R2.

По сравнению с линейкой 8000 и своим ближайшим аналогом 8450 (тоже All-Flash модель), 9450 имеет улучшенную аппаратную платформу, которая позволяет достигать гораздо более высоких показателей производительности и масштабируемости. Согласно исследованиям HPE, 3PAR 9450 может выдавать до 2 миллионов IOPS и иметь до 18 ПБ* полезной емкости (с учетом дедупликации и компрессии). С другой стороны, 8450 обеспечивает более высокую плотность размещения в стойке благодаря компактному основному шасси, которое поддерживает установку накопителей.

Основные отличия 3PAR 8450 и 9450:

| 8450 | 9450 | |

| Количество процессоров на контроллер | 1 | 2 |

| Количество микросхем ASIC на контроллер | 1 | 2 |

| Количество слотов расширения на контроллер | 1 | 5 |

| Встроенные порты для репликации по IP | 1 Гбит/с | 10 Гбит/с |

| Объем кэша на контроллерную пару | 192 ГиБ** | 448 ГиБ** |

| Максимальная «сырая»*** емкость | 3351 ТиБ**** | 6000 ТиБ**** |

| Форм-фактор основного шасси | 2U, с накопителями (полки расширения опциональны) | 5U, без накопителей (полки расширения обязательны) |

На начало 2018 года, HPE не планирует исключать 3PAR 8450 из портфеля решений. Для заказа будут доступны обе модели. Вендор рекомендует выбирать 9450 в тех случаях, где важна производительность, а 8450 – когда необходима плотность размещения.

* ПБ – петабайт, 1 ПБ равен 1000 ТБ

** ГиБ – гибибайт, 1 ГиБ равен 230 байт (1 ГБ равен 109 байт)

*** Без учета RAID, дедупликации и компрессии

**** ТиБ – тебибайт, 1 ТиБ равен 1024 ГиБ

Что такое программно-определяемое хранилище (Software Defined Storage, SDS)?

Программно-определяемое хранилище – способ построения системы хранения данных, при котором на серверной платформе (или нескольких платформах) с локальными накопителями разворачивается специальное ПО, превращающее локальные дисковые емкости в СХД с общим доступом. Данные емкости становятся доступны не только серверу, к которому они физически подключены, но и всем серверам, образующим SDS-группу, а в некоторых случаях – и другим устройствам по стандартным протоколам (iSCSI, FC, SMB и т.д.).

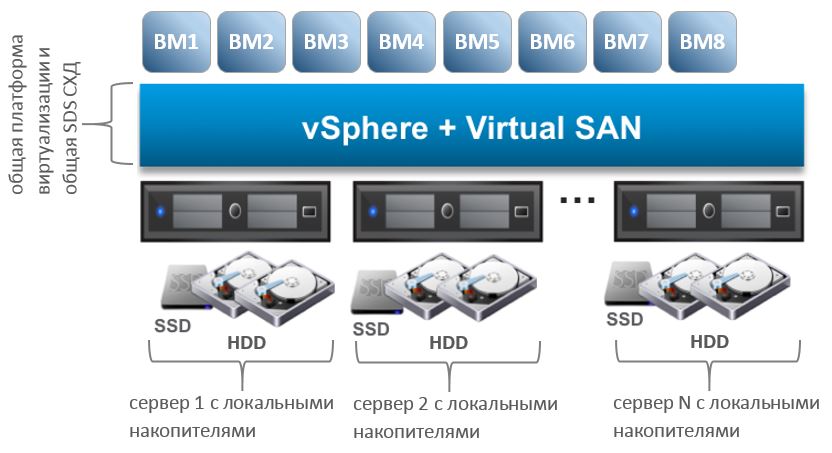

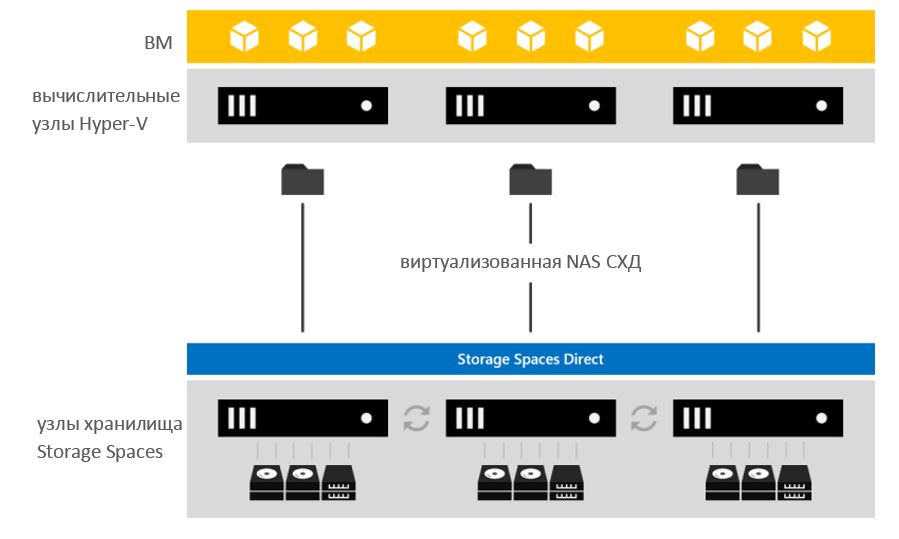

Существуют два основных способа организации подобного хранилища. В первом случае функционал SDS встроен в платформу виртуализации (гипервизор). При таком подходе программно-определяемое хранилище жестко зависит от конкретного гипервизора и работает только в связке с ним. Примерами подобных решений служат VMware vSAN, Microsoft Storage Spaces.

VMware vSAN работает только вместе с платформой виртуализации vSphere. Данное решение позволяет объединить емкости локальных накопителей серверов виртуализации в общий пул, полный доступ к которому имеет каждый узел. Подобная схема логически образует гиперконвергентную систему – на аппаратных серверах работают виртуальные машины (ВМ), используя емкости хранилища тех же самых серверов. Microsoft Storage Spaces помогает организовать как аналогичное гиперконвергентное решение, так и конвергентное, где одни узлы используются для вычислений и работы ВМ, а другие объединены в логическое виртуализованное NAS* хранилище.

Организация гиперконвергентного решения в VMware vSAN

Организация конвергентного решения в Microsoft Storage Spaces

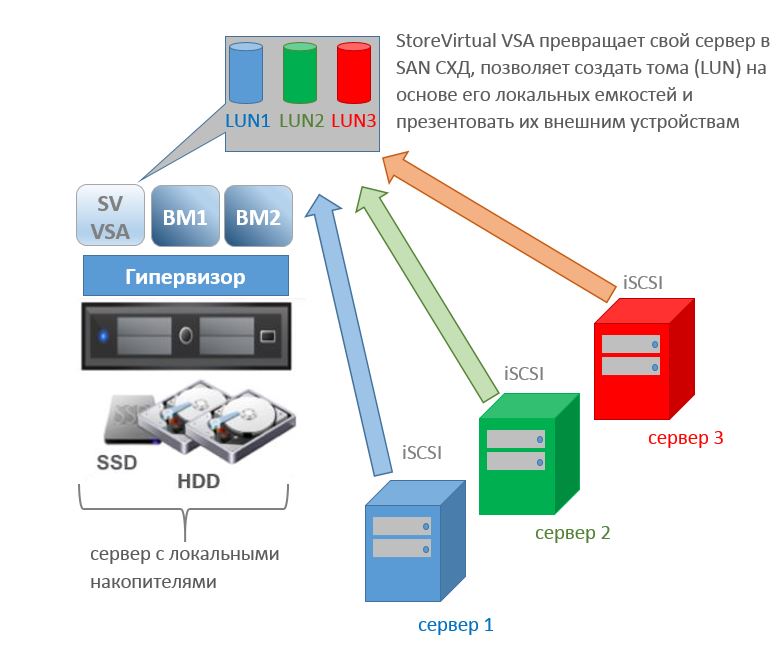

При втором способе функционал SDS заключен в специальной ВМ, которая должна быть запущена на сервере или серверах, выделенных под организацию хранилища. Эта ВМ может запускаться на любом аппаратном сервере при условии поддержки ее гипервизором. Наряду с ней на данной вычислительной платформе могут работать и другие ВМ с приложениями заказчика. Примерами подобных решений служат Dell EMC ScaleIO, HPE StoreVirtual VSA. Данные решения позволяют на базе стандартных серверов с локальными накопителями организовать блочную SAN** СХД, доступ к которой могут осуществлять все устройства по протоколу iSCSI.

Схема работы HPE StoreVirtual VSA

Преимуществами SDS решений являются:

- Гибкость в выборе аппаратной платформы и накопителей.

- Широкие возможности масштабирования.

- Возможность сокращения количества оборудования при гиперконвергентных развертываниях.

- Возможность организации сетевых RAID для повышения производительности и/или отказоустойчивости.

- Управление хранилищем через те же инструменты, что и виртуализацией (для SDS, функционал которых встроен в платформу виртуализации).

* NAS – англ. Network Attached Storage, сетевое файловое хранилище

** SAN – англ. Storage Area Network, сеть хранения данных

Что такое виртуальная ленточная библиотека? Какие виртуальные библиотеки предлагает компания HPE?

Виртуальная ленточная библиотека (англ. Virtual Tape Library, VTL) – дисковая СХД, эмулирующая ленточную библиотеку. Используется для резервного копирования (РК) ИТ-инфраструктур и приложений, для которых нецелесообразно применять традиционные ленточные устройства по таким причинам, как производительность. Преимущества виртуальных ленточных библиотек перед обычными:

- Дисковая СХД характеризуется гораздо более высокой производительностью при записи резервных копий и их последующем восстановлении.

- Дисковые массивы, в отличие от лент, в большинстве своем поддерживают дедупликацию, что увеличивает фактическую емкость СХД.

- Также VTL могут поддерживать репликацию, что упрощает передачу данных между площадками и консолидацию в главном ЦОД.

- Одна VTL может эмулировать сразу несколько библиотек, что позволяет осуществлять одновременное РК разных приложений или производить восстановление одного приложения параллельно с РК другого.

Современные виртуальные библиотеки совместимы с большинством ПО резервного копирования, что обеспечивает дополнительное удобство при организации процесса РК.

В портфеле решений HPE виртуальные ленточные библиотеки представлены семейством StoreOnce. Оно включает ряд аппаратных дисковых массивов, различающихся по максимальной емкости и производительности, а также решение StoreOnce VSA. VSA представляет собой виртуальную машину для VMware ESXi / Microsoft Hyper-V / Linux KVM, которая при развертывании на любом аппаратном сервере превратит его в программно-определяемую систему StoreOnce. Последние версии VSA можно также разворачивать на облачной платформе Microsoft Azure. VSA лицензируется по объему данных, который планируется в ней хранить, при этом лицензия на 1 ТБ доступна бесплатно.

Системы StoreOnce в качестве целевых ресурсов для РК поддерживают эмуляцию ленточных библиотек с подключением по iSCSI / FC, создание общих папок SMB / NFS, а также специальных ресурсов StoreOnce Catalyst. Протокол Catalyst, разработанный компанией HPE, позволяет (при условии поддержки ПО РК) осуществлять дедупликацию по выбору администратора на источнике, на локальном либо облачном StoreOnce. Это обеспечивает дополнительную гибкость решения и, в частности, помогает уменьшить нагрузку на сетевые каналы связи.

HPE StoreOnce 3540

Какие модели входят в линейку СХД HPE 3PAR 8000? В чем различия между ними?

HPE 3PAR StoreServ – семейство систем хранения данных, отличающихся уникальной аппаратной архитектурой. К ее особенностям относятся низкоуровневая виртуализация хранилища, когда данные любого тома распределяются по всем накопителям, использование специальных вычислительных микросхем ASIC, и принцип работы контроллеров Full Mesh, когда все они обслуживают каждый том. Указанные решения позволяют достичь весьма высоких показателей производительности и надежности, близких к показателям систем премиум-класса (англ. High-End). Они реализованы во всех массивах 3PAR, от самого младшего до самого старшего. Кроме того, все СХД имеют одну и ту же операционную систему (3PAR OS) и единый интерфейс управления (3PAR StoreServ Management Console).

К семейству относятся 3 линейки – линейка начального уровня 3PAR 8000, линейка среднего класса 3PAR 9000 и линейка премиум-класса 3PAR 20000 R2. В линейку 9000 входит только одна модель – 3PAR 9450. В каждую из оставшихся линеек входят 4 модели.

К линейке 3PAR 8000 относятся следующие модели:

- 3PAR 8200

- 3PAR 8400

- 3PAR 8440

- 3PAR 8450 All-Flash*

Основными различиями между данными моделями является максимальное количество контроллеров (2 или 4), а также максимальное количество HDD/SSD накопителей и полок расширения. Более подробное описание различий приведено в таблице:

| 8200 | 8400 | 8440 | 8450 | |

| Количество контроллеров в системе | 2 | 2 или 4 | 2 или 4 | 2 или 4 |

| Тип процессоров | 2,2 ГГц 6 ядер | 2,2 ГГц 6 ядер | 2,4 ГГц 10 ядер | 2,4 ГГц 10 ядер |

| Количество процессоров в системе | 2 | 2 или 4 (зависит от кол-ва контроллеров) | 2 или 4 (зависит от кол-ва контроллеров) | 2 или 4 (зависит от кол-ва контроллеров) |

| Количество микросхем ASIC в системе | 2 | 2 или 4 (зависит от кол-ва контроллеров) | 2 или 4 (зависит от кол-ва контроллеров) | 2 или 4 (зависит от кол-ва контроллеров) |

| Объем кэш-памяти контроллеров в системе | 64 ГиБ** | 64 или 128 ГиБ (зависит от кол-ва контроллеров) | 192 или 384 ГиБ (зависит от кол-ва контроллеров) | 192 или 384 ГиБ (зависит от кол-ва контроллеров) |

| Количество слотов расширения в системе | 2 | 2 или 4 (зависит от кол-ва контроллеров) | 2 или 4 (зависит от кол-ва контроллеров) | 2 или 4 (зависит от кол-ва контроллеров) |

| Встроенные порты FC 16 Гбит в системе | 4 | 4 или 8 (зависит от кол-ва контроллеров) | 4 или 8 (зависит от кол-ва контроллеров) | 4 или 8 (зависит от кол-ва контроллеров) |

| Встроенные порты 1 Гбит для репликации в системе | 2 | 2 или 4 (зависит от кол-ва контроллеров) | 2 или 4 (зависит от кол-ва контроллеров) | 2 или 4 (зависит от кол-ва контроллеров) |

| Максимальное количество HDD | 240 | 576 | 960 | не поддерживаются |

| Максимальное количество SSD | 120 | 240 | 480 | 480 |

| Максимальное количество полок расширения | 9 | 22 | 38 | 18 |

| Максимальная «сырая»*** емкость | 1000 ТиБ**** | 2400 ТиБ | 4000 ТиБ | 3351 ТиБ |

| Позиционирование | наиболее бюджетная модель | поддержка 4 контроллеров | поддержка 4 контроллеров и наибольшая емкость | поддержка 4 контроллеров и All-Flash |

HPE 3PAR StoreServ 8450

* Построенная только на SSD (HDD официально не поддерживаются)

** ГиБ – гибибайт, 1 ГиБ равен 230 байт (1 ГБ равен 109 байт)

*** Без учета RAID, дедупликации и компрессии

**** ТиБ – тебибайт, 1 ТиБ равен 1024 ГиБ

Как устроены СХД HPE 3PAR 8000?

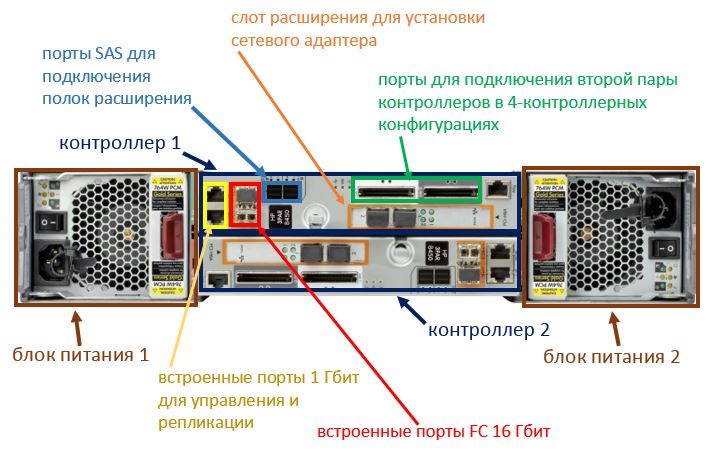

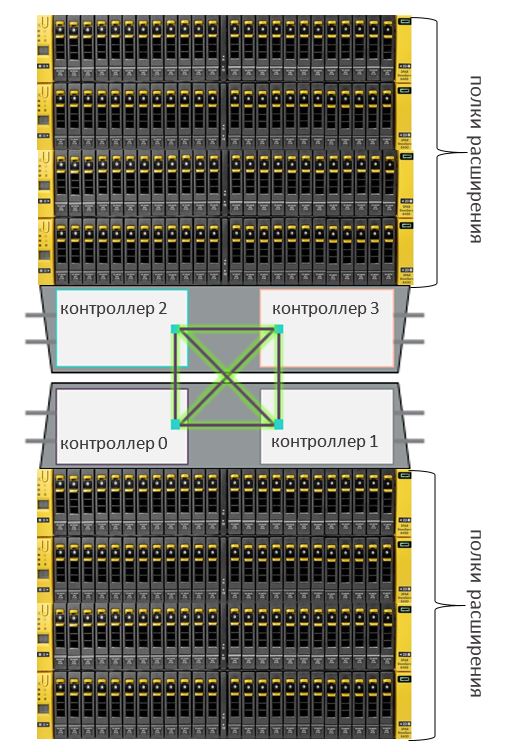

Массивы HPE 3PAR StoreServ линейки 8000 состоят из основного шасси и полок расширения. Основное шасси имеет размер 2U, включает 24 накопителя SFF, 2 блока питания и 2 контроллера. В моделях 3PAR 8400, 8440, 8450 поддерживается установка 4 контроллеров на массив – соответственно, можно использовать 2 основных шасси. Полки расширения являются опциональными. Они могут содержать 24 SFF (размер 2U) или 24 LFF (размер 4U) накопителя. Полки подключаются к основному шасси по SAS.

Каждый контроллер по умолчанию имеет 2 оптических FC 16 Гбит порта, 1 медный 1 Гбит порт для управления и 1 медный 1 Гбит порт для репликации по IP. Также каждый контроллер имеет 1 слот расширения PCIe. В него можно добавлять сетевые адаптеры – FC 16 Гбит, iSCSI/FCoE 10 Гбит, Ethernet 1 Гбит и 10 Гбит для файлового доступа, а также комбинированные (по 2 порта на каждый протокол) FC/Ethernet и iSCSI/Ethernet.

HPE 3PAR StoreServ линейки 8000 – основное шасси, вид спереди

HPE 3PAR StoreServ линейки 8000 – основное шасси, вид сзади

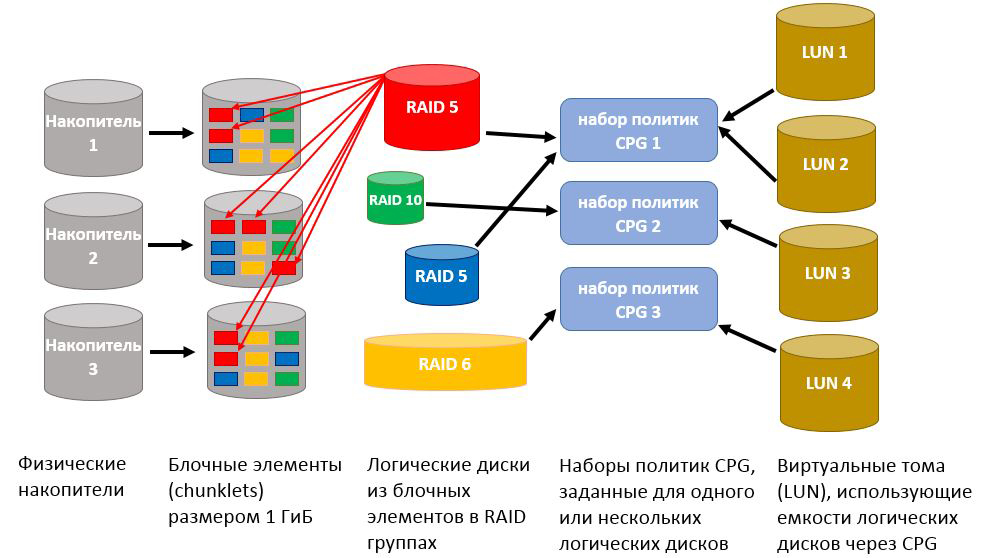

Во всех массивах 3PAR реализована технология низкоуровневой виртуализации хранилища. Емкость каждого накопителя в СХД разделяется на блочные элементы (англ. Chunklets) равного объема (1 ГиБ*), идущих последовательно друг за другом в пределах данного накопителя. Затем блочные элементы с разных накопителей объединяются в группы, аналогичные RAID группам с заданным уровнем (5, 6, 10), в которых единицей выступает не накопитель, а блочный элемент. Данные группы носят название логических дисков. Далее для нескольких логических дисков задается набор политик CPG (англ. Common Provisioning Group), который определяет, на каких накопителях и в рамках какой RAID группы будет располагаться виртуальный том. Виртуальные тома – это и есть те тома (LUN), которые предоставляются серверам по SAN**. Резервные накопители в 3PAR отсутствуют – под данную задачу также выделяется дополнительная распределенная по всему хранилищу емкость из блочных элементов. Технология виртуализации позволяет достичь отказоустойчивости на уровне не только накопителя, но и целой полки расширения благодаря тому, что блочные элементы, входящие в один LUN, распределяются по всем полкам в пределах массива.

HPE 3PAR StoreServ – схема виртуализации хранилища

Кроме того, в контроллерах всех массивов 3PAR, наряду с процессорами, присутствуют специальные микросхемы ASIC. Они несут ряд вычислительных задач, в частности выполняют расчет RAID и дедупликацию. Это позволяет разгрузить ЦПУ и значительно повысить общую производительность массивов. Сами контроллеры функционируют по схеме Full-Mesh – каждый из них обслуживает все тома, а в 4-контроллерных конфигурациях каждый контроллер связан с каждым другим. Это позволяет, при отказе какого-либо контроллера, сохранить данные из кэша на запись (они копируются на оставшиеся контроллеры) и избежать значительной потери производительности.

HPE 3PAR StoreServ – схема соединений контроллеров Full-Mesh

Все массивы 3PAR работают под управлением одной операционной системы (3PAR OS), имеют единый интерфейс администрирования (3PAR StoreServ Management Console) и общий набор программных функций. Также данные СХД связаны с платформой облачной аналитики StoreFront Remote, которая позволяет отслеживать состояние работы массивов и производительность, планировать расход емкости, определять неверные настройки и необходимость обновления прошивок и ПО.

* ГиБ – гибибайт, 1 ГиБ равен 230 байт (1 ГБ равен 109 байт)

** SAN – англ. Storage Area Network, сеть хранения данных

Как лицензируются программные функции в СХД HPE 3PAR?

Все технологии и программные функции, доступные в массивах HPE 3PAR StoreServ*, с точки зрения лицензирования объединены в 2 больших набора – All Inclusive Single System Software и All Inclusive Multi-System Software.

Набор All Inclusive Single System Software включает следующие технологии и функции:

- 3PAR OS со всеми функциями;

- Консоль администрирования StoreServ Management Console;

- Virtual Copy;

- Dynamic Optimization;

- Adaptive Optimization;

- Priority Optimization;

- Virtual Domains;

- Virtual Lock;

- File Persona;

- Smart SAN;

- Online Import;

- System Reporter;

- Virtual Service Processor (не включен в 3PAR 20000);

- Recovery Manager Central (RMC);

- Расширения RMC для создания консистентных (с сохранением данных приложений из оперативной памяти) снимков для VMware vSphere, Microsoft Hyper-V, SQL Server и Exchange, а также СУБД Oracle;

- ПО для запуска на вычислительных узлах (хостах).

Набор All Inclusive Multi-System Software включает следующие технологии и функции:

- Remote Copy;

- Peer Persistence;

- Cluster Extension (CLX);

- Объединение нескольких массивов в федерацию с поддержкой Peer Motion.

Набор All Inclusive Single System Software поставляется по умолчанию с любым массивом 3PAR и не требует дополнительного приобретения каких-либо лицензий. Набор All Inclusive Multi-System Software является опциональным и требует приобретения одной лицензии на массив. Кроме того, функционал шифрования с накопителями Self-Encrypting Drives не входит в указанные наборы функций и должен лицензироваться отдельно (также одна лицензия на массив).

* здесь и далее имеются в виду текущие линейки массивов 3PAR – 8000, 9000 и 20000.

Что такое Service Processor в СХД HPE 3PAR?

Service Processor (SP) – решение, обеспечивающее удаленный мониторинг и удаленный доступ к массиву 3PAR для службы технической поддержки HPE. SP является связующим звеном между массивом заказчика и сервисным центром HPE. Доступ происходит по защищенному HTTPS каналу. Он необходим в случаях удаленной диагностики, решения проблем и обновления ПО специалистом поддержки. SP требуется для каждого массива HPE 3PAR StoreServ линейки 8000.

SP может поставляться в одном из двух вариантов – как виртуальная машина для VMware ESXi или Microsoft Hyper-V (Virtual SP), либо как аппаратный сервер размером 1U (Physical SP). Лицензия на Virtual SP включается в набор функций All Inclusive Single System Software, который входит в поставку каждого массива 3PAR. Данный вариант выбирается по умолчанию при заказе массива. Physical SP должен приобретаться дополнительно и доступен в конфигурациях с одним либо двумя блоками питания.

Какие решения по хранению данных компании HPE поддерживают прямое подключение к серверам?

На начало 2018 года, из поставляемых HPE систем хранения прямое (без необходимости в SAN-коммутаторах*) подключение к серверам поддерживают следующие модели:

- СХД MSA 1040, 2040, 2042, 1050, 2050, 2052.

- СХД 3PAR StoreServ линеек 8000, 9000 и 20000 (только по FC с некоторыми моделями адаптеров главной шины).

- DAS** решения D2700, D3600, D3610, D3700, D3710, D6020.

* SAN (англ. Storage Area Network) – сеть хранения данных.

** DAS (англ. Direct Attached Storage) – полки с накопителями без собственных контроллеров, подключаемые к контроллеру сервера или СХД и принадлежащие только данному серверу/СХД. Существует также зонированный DAS, когда полка подключается к нескольким серверам, но каждому принадлежит только конкретная группа накопителей, без общего доступа.

В чем особенности технологий организации оперативной памяти UDIMM, RDIMM, LRDIMM и NVDIMM?

В настоящее время, имеют распространение следующие технологии организации оперативной памяти:

UDIMM (англ. Unbuffered DIMM) – небуферизованная память. Обычные планки ОЗУ, которые устанавливаются в персональных компьютерах и некоторых серверах начального уровня. Поддерживается установка до двух планок памяти на канал. Как правило, память типа UDIMM поддерживает технологию автоматической коррекции ошибок ECC, а объем одной планки составляет не более 16 ГБ.

RDIMM (англ. Registered DIMM) – регистровая память. Планки ОЗУ, широко применяющиеся в серверах. Снабжены специальным регистром, который буферизует управляющие и адресные команды контроллера памяти. Благодаря этому, снижается нагрузка на контроллер и появляется возможность использовать более объемные планки памяти и в большем количестве в рамках одного сервера. Объем планки типа RDIMM может достигать 32 ГБ.

LRDIMM (англ. Load-Reduced DIMM) – память со сниженной нагрузкой. Еще один тип ОЗУ с механизмом буферизации. В отличие от RDIMM, здесь в буфер отправляются не только управляющие и адресные команды, но и собственно данные. Эта технология позволяет значительно снизить нагрузку на контроллер памяти и использовать планки емкостью до 128 ГБ. Кроме того, в отличие от RDIMM, при использовании более двух планок LRDIMM на канал не снижается скорость работы памяти.

NVDIMM (англ. Non-Volatile DIMM) – энергонезависимая память. Технология организации ОЗУ с возможностью сохранения загруженных в память данных при штатном либо аварийном завершении работы системы. Память типа NVDIMM может использовать емкости флэш-накопителей (например, SSD) в качестве энергонезависимого хранилища, либо иметь специальный резервный модуль энергонезависимой флэш-памяти, в который будут переписываться данные при завершении работы.

Комбинировать память UDIMM, RDIMM и LRDIMM в рамках одного сервера не допускается. Требования к NVDIMM могут быть разными у разных производителей. Компания HPE в рамках новой серии Persistent Memory анонсировала планки NVDIMM на 8 ГБ для серверов DL360 Gen.9 и DL380 Gen.9. Для одного сервера допускается установка до 16 планок NVDIMM и имеется возможность совмещать их с RDIMM. При использовании HPE NVDIMM требуются процессоры Intel Xeon E5-2600 v4, наличие батареи поддержки кэш-памяти HPE Smart Storage Battery (в качестве источника питания при перезаписи данных в энергонезависимый модуль) и как минимум одной планки RDIMM.

Что такое репликация? В чем отличия синхронной и асинхронной репликации?

Репликация – процесс передачи данных с одного устройства хранения на другие с целью создания резервной копии этих данных, обеспечения сценариев высокой доступности или катастрофоустойчивости. Существует 2 типа репликации: синхронная и асинхронная.

| Синхронная репликация | Асинхронная репликация | |

| Принцип действия |

|

|

| Достоинства | Основная СХД подтверждает серверу, что данные записаны, только после того, как запишет данные себе и получит подтверждение о записи от резервной СХД. Данные пишутся синхронно на обе СХД, что дает гарантию 100% сохранения данных при выходе из строя основной СХД. | Не обязательны дорогостоящие быстрые каналы связи. |

| Недостатки | Высокие требования к ширине (рекомендуется 10Gb) и длине канала для минимизации задержки при записи на резервную СХД и, соответственно, высокая стоимость организации такого решения. | Основная СХД подтверждает серверу, что данные записаны, после того как запишет данные только себе, что не дает 100% гарантии сохранения всех данных при выходе из строя основной СХД. |

В системах хранения компании HPE имеются следующие решения по репликации:

- Remote Snap – асинхронная репликация в MSA.

- Remote Copy – асинхронная репликация в StoreVirtual.

- Remote Copy Software – комплексное решение в 3PAR, включающее асинхронную и синхронную репликацию с несколькими режимами работы.

Что такое RPO и RTO?

При организации репликации для систем хранения обычно оперируют двумя показателями.

Recovery Point Objective (RPO) – допустимый объем возможных потерь данных в случае сбоя (потерю данных за какой промежуток времени мы можем допустить). Измеряется в секундах.

Recovery Time Objective (RTO) – допустимое время простоя системы в случае сбоя. Измеряется в секундах.

В случае с синхронной репликацией значение RPO стремится к 0, но зато предъявляются более высокие требования к каналам связи.

В случае с асинхронной репликацией значение RPO будет не 0. В системах хранения HPE, как правило, значение варьируется от 5 минут до 24 часов.

Что такое тиринг? Что такое MSA Virtual Tier Affinity?

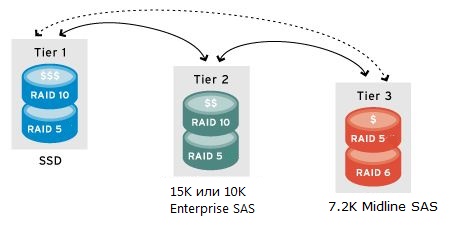

Тиринг (англ. Tiering) – это технология, с помощью которой СХД может самостоятельно перераспределять данные по накопителям на основе частоты их использования. Редко используемые данные перемещаются на более медленные накопители, а часто используемые – на более быстрые.

Тиринг дает возможность сэкономить на дорогих HDD или SSD, позволяя приобрести их в небольшом количестве и использовать более дешевые и объемные NLSAS/SATA для хранения основных данных, которые не используются в текущий момент. Согласно статистическим показателям, до 70% данных располагается на медленных дисках при использовании тиринга.

Как правило, в СХД выделяется 3 уровня или «тира» (от англ. Tier):

- Tier1 – самая производительная группа SSD накопителей;

- Tier2 – быстрые диски SAS Enterprise на высокопроизводительном массиве RAID10;

- Tier3 – самая низкопроизводительная группа дисков SATA/SAS (Midline или Nearline) в RAID5/6.

На большинстве современных СХД тиринг работает в автоматическом режиме. Система самостоятельно анализирует частоту обращений к различным блокам данных того или иного LUN и перемещает их между уровнями хранения. Данный режим называется sub-LUN tiering. У HPE в некоторых СХД для него принято название Adaptive Optimization. Некоторое время назад был распространен ручной режим тиринга, когда система могла осуществить перенос только всего LUN и только по команде администратора. Этот функционал у HPE носит название Dynamic Optimization.

Сегодня тиринг реализован на всех основных SAN СХД компании HPE: MSA, StoreVirtual, 3PAR. Для его активации может потребоваться приобретение дополнительной лицензии.

Virtual Tier Affinity – дополнительное улучшение для тиринга в массивах HPE MSA, приоритизация данных на уровне LUN (механизм «Quality of Service»). Администратор может выставить для каждого LUN высокий, либо низкий приоритет. В первом случае данные LUN быстрее станут попадать на самый производительный уровень хранения и дольше там находиться. Во втором случае данные по умолчанию будут записываться на архивный (наименее производительный) уровень и быстрее туда опускаться в случае последующего поднятия.

Что такое дедупликация? В чем ее отличие от компрессии (сжатия данных)?

Дедупликация – это технология, которая позволяет находить и исключать одинаковые (дублирующиеся) данные в рамках системы хранения с целью экономии дисковых объемов. С включенной дедупликацией одинаковые данные не будут записываться на накопители при последующих циклах записи, а будет записываться лишь ссылка на те данные, что уже записаны. Дедупликация бывает файловая и аппаратная.

В случае с файловой дедупликацией, операционная система отслеживает полностью идентичные файлы и хранит только одну копию этих файлов. Например, когда сотрудник внутри организации делает рассылку с вложением, на почтовом сервере Exchange это вложение сохраняется в единственном экземпляре. Получатели данного письма при открытии вложения просто перейдут по ссылке на этот файл.

Аппаратная дедупликация работает не на уровне идентичных файлов, а на уровне блоков данных. В этом случае, проверкой блоков занимается не операционная система, а контроллер системы хранения.

В системах хранения HPE дедупликация реализована для следующих моделей:

- 3PAR StoreServ, StoreOnce – аппаратная дедупликация;

- StoreEasy – программная дедупликация средствами Windows Storage Server.

Компрессия (сжатие данных) – еще одна технология, позволяющая экономить объемы хранилища путем уменьшения размеров хранимых данных. В отличие от дедупликации, она не исключает копии, а посредством различных алгоритмов уменьшает размер (производит сжатие) имеющихся данных.

Как и дедупликация, компрессия бывает файловая и аппаратная.

При файловой компрессии, операционная система или специальное ПО пытается найти избыточные фрагменты в составе каждого файла и удалить их, что приведет к уменьшению его общего размера. Например, для текстового файла могут быть убраны ненужные пробелы в конце, а повторяющиеся слова или символы заменены особым, более компактным кодированием. Для изображений удаляются избыточные пиксели, в аудиофайлах исключаются малозаметные для слуха звуковые эффекты.

При аппаратной компрессии происходит сжатие блоков данных по специальным алгоритмам. Аппаратную компрессию выполняет контроллер системы хранения.

Процесс компрессии может происходить с потерями (англ. lossy), либо без потерь (англ. lossless). В первом случае исходные данные уже не могут быть полноценно восстановлены из сжатых данных. Такие результаты допустимы при сжатии изображений или аудио, где небольшое снижение качества является приемлемым. Во втором случае возможность восстановления предусматривается, что является предпочтительным для корпоративных СХД, хранящих важные данные.

Как правило, в системах хранения, поддерживающих и дедупликацию и компрессию, для оптимального использования вычислительных ресурсов вначале выполняется дедупликация, а затем – компрессия, которая затрагивает только оставшиеся данные и не применяется к тем данным, которые все равно будут удалены дедупликацией.

В системах хранения HPE реализация аппаратной компрессии в ближайшем будущем предполагается для 3PAR StoreServ.

Что такое inline и post-processing режимы дедупликации и компрессии? Что показывает коэффициент дедупликации/компрессии?

Дедупликация и компрессия могут происходить в режиме реального времени (англ. inline), либо в режиме последующей обработки (англ. post-process). В первом случае данные подвергаются обработке, еще находясь в памяти, и уже затем записываются на накопители. Этот метод обеспечивает экономию места и меньшую нагрузку на дисковую подсистему, однако нагрузка на вычислительные ресурсы является существенной. Во втором случае данные записываются на накопители без изменений, а затем подвергаются дедупликации или компрессии согласно установленному расписанию. Это обеспечивает экономию вычислительных ресурсов и в некоторых случаях ускоряет первоначальную запись данных, однако требует больше места на дисках.

Важно отметить, что эффективность дедупликации и компрессии напрямую зависит от состава и структуры конкретных данных, к которым планируется применять указанные технологии. К примеру, для компрессии хорошо подходят транзакционные БД, где в рамках каждого экземпляра базы часто встречаются повторяющиеся последовательности данных. Дедупликация результативна в средах виртуализации и VDI, в которых попадается множество очень похожих файлов виртуальных машин. В некоторых же случаях, положительного эффекта от дедупликации и компрессии может не быть вовсе или он будет минимальным.

Количественным показателем эффективности указанных технологий в каждом конкретном случае является коэффициент дедупликации или компрессии, который записывается в формате A:B. Данное выражение показывает отношение объема, который должен был быть занят на СХД без учета действия технологий (значение A), к тому объему, который оказался реально занят после применения дедупликации или компрессии (значение B). Например, при коэффициенте дедупликации 2:1 данные, имеющие объем 2 ТБ, после применения технологии займут на СХД в 2 раза меньше места – лишь 1 ТБ.

Что такое сетевой RAID (на примере HPE StoreVirtual 3200)?

Сетевой RAID по принципу своей работы аналогичен классическому RAID, только его элементами являются не отдельные диски, а отдельные контроллеры. Тома (LUN) обслуживаются всеми участвующими контроллерами, при этом уровень сетевого RAID мы можем задавать на уровне конкретного тома. К примеру, в рамках одного кластера для первого тома мы можем настроить сетевой RAID 10, а для второго – сетевой RAID 0. После этого, блоки данных в указанных томах будут записываться и распределяться соответственно уровню сетевого RAID.

В настоящее время, для SV3200 доступны следующие уровни сетевого RAID: 0, 10. Уровень 0 представляет собой обычное чередование записываемых блоков данных между контроллерами, и может быть реализован как в кластере, так и для единственной SV3200 (для двух ее контролеров). В случае сетевого RAID 10 при записи данных происходит чередование записываемых блоков между двумя контроллерами одной, а затем зеркалирование записанных данных на другую СХД. Данные уровни в сетевом RAID работают точно так же, как и в обычном (см. рисунок).

Какие новые технологии реализованы в серверах HPE ProLiant Gen.10?

В 10м поколении серверов ProLiant HPE реализовал новые, не использовавшиеся ранее технологии. Это позволило улучшить показатели производительности, надежности и безопасности серверов.

Из основных усовершенствований стоит выделить:

- Набор технологий HPE Intelligent System Tuning, позволяющий повысить производительность процессоров Intel Xeon и оптимизировать настройку BIOS. Включает следующие технологии:

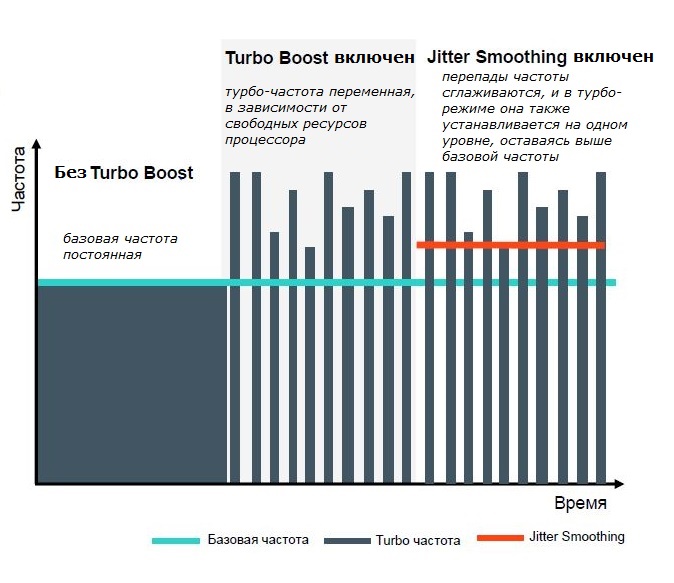

- Jitter Smoothing – уменьшение перепадов и выравнивание частоты процессора в режиме Turbo Boost. Позволяет уменьшить задержки обращения к памяти, что вызывает дополнительный прирост производительности в некоторых требовательных приложениях (например, Java). Требует лицензию iLO Advanced или выше.

- Core Boosting – дополнительное повышение частоты активных ядер в режиме Turbo Boost. Позволяет оставаться на том же уровне производительности, используя меньшее число ядер. В схемах лицензирования по количеству ядер (например, в СУБД), может обеспечить экономию лицензий. Требует лицензию iLO Advanced или выше, работает только на определенных процессорах.

- Workload Matching – использование предопределенных профилей настроек BIOS для распространенных серверных задач (виртуализация, СУБД, обработка графики и т.д.). Позволяет уменьшить число ошибок и повысить эффективность настройки BIOS (по сравнению с заданием каждого отдельного параметра вручную). По данным HPE, использование этой технологии увеличивает производительность системы до 9%.

- Jitter Smoothing – уменьшение перепадов и выравнивание частоты процессора в режиме Turbo Boost. Позволяет уменьшить задержки обращения к памяти, что вызывает дополнительный прирост производительности в некоторых требовательных приложениях (например, Java). Требует лицензию iLO Advanced или выше.

- Функция отказоустойчивости оперативной памяти HPE Fast Fault Tolerance. Данная функция ведет мониторинг сбоев и определяет местоположение ошибок. При обнаружении ошибки, соответствующая область памяти изолируется, и на время ее исправления скорость работы снижается только для этой области. Остальные области продолжают работу на своей обычной скорости. Использование Fast Fault Tolerance вместе со стандартными технологиями обеспечения высокой доступности памяти (исправление ошибок, резервирование ранков, зеркалирование и т.д.) снижает время среднегодового простоя серверов на 85% (по данным HPE).

- Усовершенствования подсистемы хранения:

- Увеличенное количество отсеков под накопители во многих серверах Gen.10.

- Использование внутренней корзины под LFF накопители в DL380 Gen.10.

- Поддержка увеличенного числа NVMe накопителей и внутренних M.2 накопителей на многих серверах Gen.10.

- Новая версия контроллера удаленного управления iLO5:

- В 2 раза более производительный по сравнению с iLO4 (по данным HPE).

- Технология аппаратного ключа HPE Silicon Root of Trust:

- Автоматическая проверка целостности и подлинности прошивок iLO и остальных компонентов сервера (BIOS, контроллеров, адаптеров и т.д.) в процессе работы. Исключает возможность злонамеренной подмены и модификации прошивок. Сторонние комплектующие при попытке установки их в сервер не пройдут проверку и с высокой вероятностью не будут распознаны. Для проверки iLO и BIOS требуется лицензия iLO Advanced Premium Security Edition.

- Безопасная загрузка сервера с функцией автоматического восстановления прошивок iLO из репозитория в случае неполадки или взлома. Требуется лицензия iLO Advanced Premium Security Edition.

- Безопасное (без возможности восстановления) удаление пользовательских данных и настроек с контроллера iLO. Требуется лицензия iLO Advanced Premium Security Edition.

- Защита канала управления с использованием высочайшей коммерчески доступной стойкости шифрования. В зависимости от используемого алгоритма, может потребоваться лицензия iLO Advanced Premium Security Edition.

- Сервисный порт iLO. Выделенный USB порт для iLO, к которому можно подключить ноутбук (через адаптер USB-Ethernet) с целью диагностики и управления. Также можно скопировать журналы Active Health System на USB флэш накопитель.

- Соответствие iLO REST API интерфейсу Redfish API – стандарту управления серверами, пришедшему на смену IPMI. Администратор получает возможность использовать сторонние средства, поддерживающие этот интерфейс, для мониторинга и управления серверами HPE.

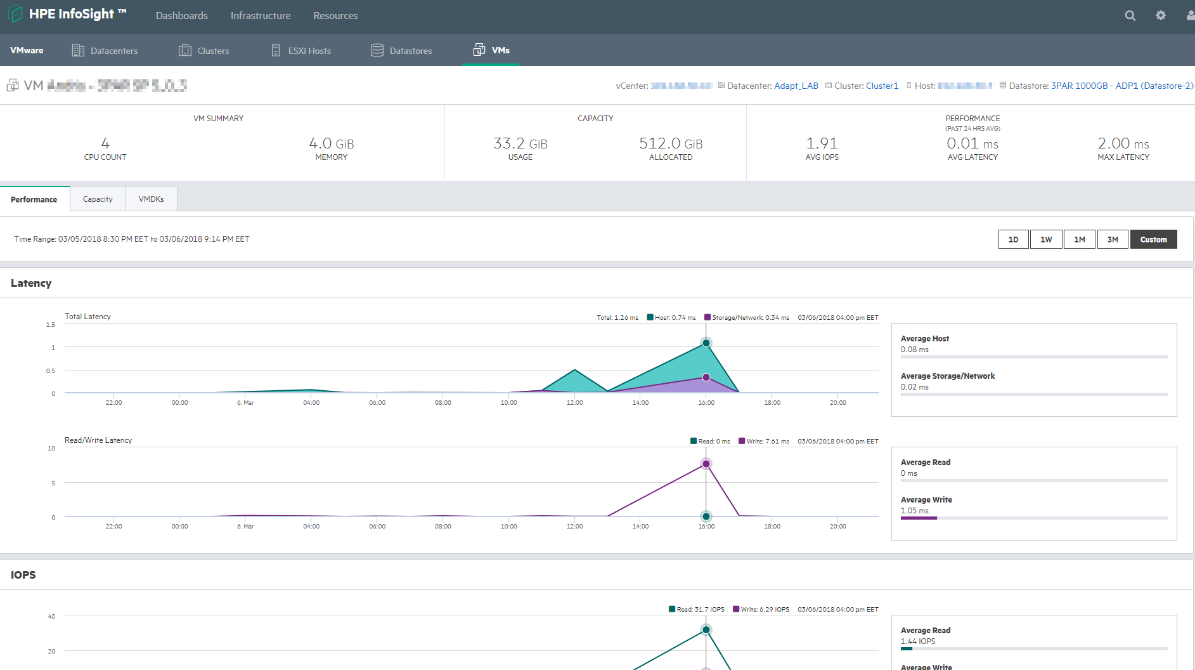

Что такое Nimble Storage InfoSight? Каковы особенности ее работы?

HPE Nimble Storage – семейство систем хранения данных. Отличительные черты этих СХД – частичное (наряду с HDD), либо полное (all-flash) использование SSD накопителей во всех моделях, а также очень высокий уровень надежности. HPE заявляет о доступности Nimble Storage в 99,9999%, что достигается благодаря применению платформы облачной аналитики InfoSight. Относительно недавно была добавлена поддержка линейки продуктов HPE 3PAR в InfoSight.

Данная технология позволяет СХД непрерывно в автоматическом режиме собирать большое количество данных как о собственном состоянии, так и об окружающей инфраструктуре (подключенные сети, серверы, платформы виртуализации). Затем эти показатели отправляются в облачную систему, где с помощью сложных аналитических алгоритмов выявляются текущие проблемы и делаются прогнозы о будущем состоянии инфраструктуры. На основе данных выводов заказчику предоставляются автоматические исправления и рекомендации для администратора СХД. Например, при обнаружении у одного из клиентов проблемы в совместимости микропрограммы контроллеров СХД с приложениями гипервизора система автоматически заблокирует возможность установки данной версии прошивки на СХД у других клиентов, а тем у кого уже установлена схожая конфигурация будет предложен критический апдейт системы.

Такой подход помогает предотвращать сбои до их возникновения, причем во многих случаях без вмешательства администратора. По данным вендора, при использовании InfoSight 86% проблем разрешаются без участия ИТ-службы. Сюда входят инциденты как с самой СХД, так и с окружающей инфраструктурой. Причем по данным HPE, более половины проблем, как правило, не связаны с СХД.

InfoSight позволяет значительно сократить время на поиск проблемных узлов инфраструктуры в случае деградации производительности. Система в удобном графическом виде показывает текущее время отклика и статистику задержек за определенный период по проблемной ВМ не только относительно самой СХД, но и сети передачи данных SAN, а также приложений гипервизора. Отклонение каких-либо показателей в кратчайшие сроки позволит определить «узкое место» инфраструктуры. Не нужно переключаться между несколькими системами мониторинга, все показатели доступны в едином портале, так как InfoSight интегрируется с VmWare VCenter.

Благодаря оценке статистической информации сразу по большому количеству СХД, система позволяет провести более точный сайзинг инфраструктуры, чем это бы делалось в любом оффлайн-сайзере. Тем самым становится возможно более точно строить планы апргрейда, сократив, возможно излишние затраты на покупку ненужных компонентов.

Облачная система InfoSight является единой для заказчиков Nimble Storage по всему миру. Она использует общие базы и машинное обучение на основе уже имеющихся данных для постоянного совершенствования своих прогнозов. Собранные данные хранятся на вычислительных мощностях InfoSight в США.

В процессе диагностики собирается только служебная информация, собственные данные заказчика не затрагиваются.

Информация передается по защищенному SSL каналу. Некоторые примеры передаваемых данных:

- Серийный номер массива.

- Базовая информация о работоспособности (health check).

- Системные журналы событий.

- Параметры настроек системы.

- Статистика работы системы.

Иногда, для устранения определенных проблем требуется снятие содержимого памяти контроллера (core data dump). В полученный снимок могут попасть некоторые пользовательские данные. В такой ситуации заказчик по своему желанию может разрешить передачу снимка в поддержку Nimble Storage. Передача не является обязательной, однако без нее возможности специалистов поддержки по работе над проблемой будут ограничены.

В случае своего согласия, заказчик оформляет письменное разрешение, отправляет его в поддержку Nimble и инициирует передачу снимка. Передача происходит по SSL каналу. HPE обязуется принять все необходимые технические меры для защиты конфиденциальности полученных данных заказчика, такие как контроль и аудит доступа персонала к данным, закрытие внешнего доступа через ACL, антивирусная защита, физическая защита серверных комнат и т.д.

Подключение СХД Nimble Storage к InfoSight осуществляется через сеть управления. Заказчик должен будет открыть следующие порты для исходящего трафика (никаких входящих соединений не требуется):

- 443/HTTPS – отправка диагностической информации, оповещений, доступ к обновлениям NimbleOS.

- 2222/SSH – установление защищенного канала через VPN и SSH для специалиста поддержки при устранении проблем.

- Также рекомендуется разрешить ICMP PING для оптимизации установления соединений.

Что такое HPE SmartCache?

Технология HPE SmartCache позволяет использовать SSD накопители в качестве дополнительной кэш-памяти. Данное решение применяется в среде DAS (внутренние накопители сервера, либо локально подключенные DAS полки).

SmartCache работает как на чтение, так и на запись. При операциях чтения часто запрашиваемые данные помещаются в кэш из SSD накопителей. Операции записи происходят вначале на SSD-кэш, а затем данные перемещаются на HDD. Благодаря тому, что SSD по сравнению с HDD имеют значительно более высокую производительность, увеличивается скорость работы приложений (по данным HPE – до 4 раз).

SmartCache доступна с контроллерами Smart Array P-класса, которые имеют кэш типа FBWC емкостью не менее 1 Гбайт. Технология может использоваться на серверах 8го и более новых поколений. Настройка производится через средство управления контроллерами Smart Array – HPE Smart Storage Administrator.

SmartCache имеет собственную лицензию, при этом для некоторых контроллеров (например, P816i-a SR Gen.10) она включается по умолчанию, а для других требуется приобретать ее отдельно.

Какие технологии реализованы в СХД HPE Nimble Storage?

- QoS (англ. Quality of Service) по IOPS и/или пропускной способности. Данная технология позволяет установить нижние и верхние ограничения для отдельных томов по указанным параметрам производительности.

- Гарантированная задержка менее 1 мс. Можно включать для отдельных томов.

- Снимки (снапшоты) и копии (клоны) томов с «тонким» выделением емкости. При создании снимка или копии проставляются только ссылки на исходный том, а фактическая емкость не выделяется. Затем, по мере изменения основного тома, измененные данные записываются на накопители рядом с исходными, на которые ведут ссылки от снимка/копии. Снимки также являются консистентными, т.е. сохраняют данные приложений из оперативной памяти.

- Шифрование и безопасное удаление данных томов. Шифрование работает на SSD и HDD, сжатие данных сохраняется. Возможно сохранение шифрования при репликации.

- Кэш чтения на SSD в моделях серий CS и SF.

- Сжатие и дедупликация в режиме реального времени. Сжатие применяется после дедупликации. Возможно включать и отключать данные функции на уровне отдельных томов. Используется алгоритм сжатия LZ4 и дедупликация с переменным блоком, с возможностью автонастройки оптимального размера блока для известных приложений.

- Асинхронная репликация с поддержкой сжатия и шифрования. Ожидается скорое добавление синхронной репликации и механизма переключения между площадками без прерывания работы.

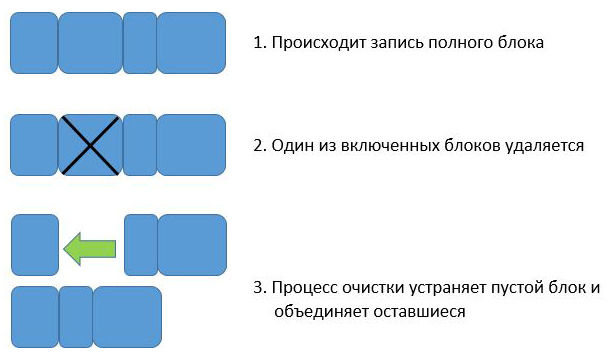

- Использование файловой системы CASL (англ. Cache Accelerated Sequential Layout). В данной файловой системе запись всегда происходит полным блоком на все накопители в RAID группе. В фоновом режиме работает процесс очистки, который устраняет пустые блоки, образованные при удалении данных, путем объединения оставшихся блоков. Эта технология обеспечивает высокую и предсказуемую скорость записи, хорошую производительность дедупликации и сжатия.

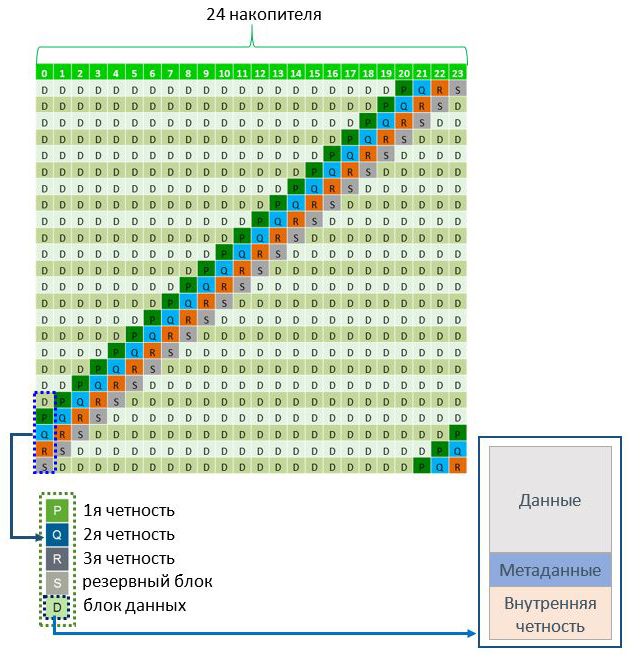

Схема работы файловой системы Nimble Storage - Triple+ Parity RAID в моделях серии AF. Собственная технология RAID с использованием тройной четности, резервного блока данных и внутренней четности накопителя. В RAID группу входят 24 накопителя (до 2 RAID-групп на массив). Технология позволяет выдержать одновременный отказ любых 3 накопителей, либо последовательный (по завершении перестроения RAID) отказ 4 накопителей (благодаря резервному блоку). Кроме того, внутренняя четность помогает восстановить 1 неисправный сектор в рамках каждого накопителя при операциях чтения.

Схема работы Triple+ Parity RAID

Чем различаются интерфейсы SAS и SATA?

В настоящее время, для подключения накопителей в персональных компьютерах, серверах и системах хранения наиболее часто используются 2 интерфейса: SAS и SATA. SAS (англ. Serial Attached SCSI) является преемником параллельной технологии SCSI (англ. Small Computer System Interface). SATA (англ. Serial ATA) – преемник параллельного интерфейса ATA (англ. Advanced Technology Attachment).

В отличие от своих предшественников, протоколы SAS и SATA предусматривают последовательную передачу данных, то есть вся информация передается единым потоком (в параллельных технологиях задействуется множество потоков). Последовательная передача данных позволяет достичь гораздо более высоких скоростей, чем параллельная. Кроме того, в протоколах SAS и SATA используется тип соединения «точка-точка» между контроллером и оконечным устройством, то есть каждый накопитель имеет полную полосу пропускания. В случае SCSI полоса пропускания общая, и она делится между всеми подключенными устройствами.

SAS по сравнению с SATA предоставляет более высокую пропускную способность и расширенную функциональность, а потому накопители на его основе чаще используются в серверах и системах хранения корпоративного класса. SATA, с другой стороны, имеет более низкую стоимость и применяется в большинстве персональных компьютеров, серверов и систем хранения начального уровня. Основные различия между протоколами:

| SATA | SAS | |

| Пропускная способность | 6 Гбит/с (SATA III) | 12 Гбит/с (SAS-3) ) |

| Набор команд | ATA | SCSI |

| Порты | 1 полудуплексный* | 2 полнодуплексных* |

| Глубина очереди | До 32 команд | До 254 команд |

| Длина кабелей | До 1 м (2 м для eSATA**) | До 10 м |

| Возможности расширения | До 15 устройств на 1 порт с использованием SATA мультипликатора | Более 65 тыс. устройств на 1 порт с использованием SAS расширителей |

| Обратная совместимость | SATA контроллер не поддерживает SAS накопители | SAS контроллер поддерживает SATA накопители |

| Дополнительные функции | Нет |

Технология Multipath I/O, позволяющая подключать накопитель по 2 каналам (через 2 порта) и осуществлять резервирование путей / балансировку нагрузки Технология проверки контрольных сумм T.10 при записи данных Технология зонинга T.10, позволяющая разбить домен SAS на зоны для удобства настройки и управления (по аналогии с VLAN) |

* полудуплексный режим работы – возможность в определенный момент времени вести только прием, либо только передачу; полнодуплексный – возможность вести прием и передачу одновременно

** eSATA – англ. External SATA, интерфейс SATA для подключения внешних устройств

Какие технологии и программные функции реализованы в СХД HPE 3PAR?

Общий обзор технологий и программных функций массивов HPE 3PAR StoreServ:

- Набор технологий уменьшения занимаемой емкости Adaptive Data Reduction. Применяется к входящим данным до их записи на накопители. Включает следующие технологии:

- Zero Detect – удаление в потоке записываемых данных последовательностей нулей, не представляющих фактической ценности (например, при инициализации виртуальных машин).

- Дедупликация страниц памяти. Метаданные дедупликации обрабатываются в микросхемах ASIC.

- Компрессия страниц памяти. Перед ее применением процессор контроллера анализирует, насколько эффективно могут быть сжаты данные, и сжимает только те, которые хорошо поддаются компрессии.

- Data Packing – объединение сжатых страниц в блоки по 16 КиБ* для сохранения эффективности компрессии.

- Технология построения файлового хранилища File Persona Software. Поддерживает широкий выбор функций и протоколов, включая SMB, NFS, FTP/FTPS.

- Набор технологий организации тиринга, обеспечения качества обслуживания (англ. Quality of Service, QoS) и осуществления миграций томов (LUN) Data Optimization Software Suite. Включает следующие технологии:

- Adaptive Optimization – автоматический перенос блоков данных между разными типами накопителей в соответствии с требованиями политик.

- Dynamic Optimization – перенос целого тома (LUN) по команде администратора.

- Priority Optimization – определение минимальных и/или максимальных допустимых значений по IOPS, пропускной способности и задержке для тома (LUN) или группы томов.

- Peer Motion – осуществление миграций томов (LUN) между разными массивами 3PAR в режиме реального времени без прерывания работы приложений.

- Набор технологий репликации, организации катастрофоустойчивых решений и снятия мгновенных снимков Replication Software Suite. Включает следующие технологии:

- Virtual Copy – снятие снимков (снапшотов) без первоначального выделения емкости. Снимок начинает занимать фактическую емкость только по мере изменения основного тома. Повторяющиеся изменения не записываются.

- Remote Copy – асинхронная и синхронная репликация.

- Peer Persistence – организация катастрофоустойчивого решения с географически распределенным вычислительным кластером, когда потеря СХД на одной из площадок не приведет к потере доступа узлов к тому (LUN).

- Набор средств мониторинга работы массива Reporting Software Suite. Включает следующие инструменты:

- System Reporter – отчеты о производительности и использовании емкости в виде наглядных графиков и диаграмм.

- 3PARinfo – утилита командной строки, используемая на сервере, подключенном к массиву, для отображения информации о предоставлении томов (LUN).

- Набор технологий разграничения прав доступа Security Software Suite. Включает следующие технологии:

- Virtual Domains – разграничение доступа пользователей, групп или приложений к хранилищу посредством создания виртуальных доменов.

- Virtual Lock – защита томов (LUN) и снимков от удаления пользователем или администратором на заданный период времени.

- Функция шифрования данных на накопителях Data at Rest Encryption. Используются специальные HDD/SSD с поддержкой шифрования (англ. Self-Encrypting Drives, SED). Шифровать можно только массив целиком, т.е. для использования данной функции все накопители должны быть SED.

- Средство миграции данных Online Import. Позволяет в режиме реального времени производить миграцию томов с массивов HPE EVA, EMC CX4 или EMC VNX на HPE 3PAR.

- Средство конфигурации Smart SAN for 3PAR. Позволяет автоматизировать настройку оборудования в SAN, задание параметров и политик. Работает с массивами HPE 3PAR, коммутаторами HPE StoreFabric B-series, адаптерами главной шины (HBA) FC 16 Гбит серий HPE Q и E.

- Средство резервного копирования Recovery Manager Central (RMC). Реализовано в виде виртуальной машины для VMware ESXi. Позволяет производить резервное копирование данных напрямую с массива HPE 3PAR на дисковую библиотеку HPE StoreOnce. Устраняет необходимость в стороннем ПО резервного копирования.

- ПО для запуска на вычислительных узлах (хостах):

- Host Explorer – запускается как агент на сервере, собирает служебные и конфигурационные данные и отправляет их на 3PAR, устраняя необходимость ввода вручную.

- Multipath I/O – реализует технологию множественных путей для некоторых серверных ОС. Позволяет серверу подключаться к массиву 3PAR по нескольким путям, распределять между ними нагрузку и обеспечивать высокую доступность.

- Cluster Extension Software (CLX) – позволяет строить распределенные катастрофоустойчивые вычислительные кластеры на базе средств кластеризации Windows и репликации 3PAR Remote Copy.

- Policy Server – устанавливается на отдельном сервере, позволяет задавать политики разрешения/запрета сервисных подключений к массиву 3PAR и подключений от массива во внешний Интернет. Также позволяет вести аудит отправки диагностических данных в службу поддержки HPE и действий в рамках разрешенных сервисных подключений.

- Дополнительные функции 3PAR OS:

- 3PAR OS Administration Tools – средства управления 3PAR OS, включающие графический интерфейс InForm Management Console и интерфейс командной строки с поддержкой сценариев (скриптов) InForm Command Line Interface.

- 3PAR Web Services API – программный интерфейс для возможности объединения средств управления 3PAR с уже имеющимися у заказчика системами администрирования.

- Autonomic Groups – группы управления, позволяющие объединить объекты в системе 3PAR (такие как виртуальные домены) для упрощения настройки, сбора статистики и других действий.

- Autonomic Rebalance – автоматическое перераспределение томов (LUN) для оптимального использования емкости при добавлении новых накопителей в массив.

- Access Guard – настройка прав доступа на уровне тома (LUN) для конкретных узлов или через конкретные порты.

- 3PAR LDAP – поддержка протокола доступа к службе каталогов LDAP (англ. Lightweight Directory Access Protocol). Позволяет связать систему учетных данных консоли управления 3PAR с развернутой в организации службой каталогов. Это упрощает процедуры аутентификации и авторизации (для доступа к консоли могут использоваться доменные учетные данные) и обеспечивает централизацию управления учетными записями.

- RAID MP (Multi-Parity) – ускоренное создание и перестроение RAID 6. Служебные расчеты производятся микросхемами ASIC.

- Full Copy – создание мгновенных копий (клонов) томов (LUN).

- Scheduler – автоматизация процедур создания и удаления снимков Virtual Copy.

- Adaptive Flash Cache – использование SSD накопителей в качестве дополнительной кэш-памяти.

- Persistent Cache – защита содержимого кэша на запись в конфигурациях с 4 и более контроллерами. При отказе контроллера данные из его кэша моментально копируются в кэш других контроллеров. Это позволяет избежать существенного падения производительности.